Le deep learning a révolutionné le monde du traitement d’images. Dans de nombreux cas, les performances atteintes sont proches de celles d’un être humain. Les cas d’échec existent cependant, et ils permettent d’apporter un éclairage sur la manière dont ces modèles fonctionnent.

Etudions trois d’entre eux pour voir ce qu’ils nous révèlent sur les rouages internes des modèles de deep learning, et sur leurs limitations.

Par Daphné Wallach, ingénieure, doctoresse en Intelligence artificielle et autrice aux Editions ENI

Une caméra intelligente confond le ballon de foot qu’elle doit suivre avec le crâne rasé de l’arbitre

Octobre 2020. Une équipe de football écossaise utilise une caméra équipée d’un modèle d’intelligence artificielle pour filmer de manière autonome son match ; le modèle d’intelligence artificielle embarqué dans la caméra lui permet théoriquement de suivre le ballon automatiquement.

Malheureusement, la caméra se fixe obstinément sur le crâne rasé de l’arbitre de touche, le confondant avec le ballon.

Mettons-nous un instant à la place du modèle : pour lui, ce crâne rasé ressemble à s’y méprendre à ce qu’il a appris à reconnaître comme un ballon de football. Tous deux sont des objets sphériques, majoritairement blancs, et qui se déplacent sur un fond de couleur verte.

Si ce modèle avait vu plus de personnes avec le crâne rasé, cependant, il aurait appris à reconnaître les différences entre les deux. Par exemple, un crâne rasé est systématiquement placé directement au-dessus d’un torse humain, ce qui n’est que rarement le cas d’un ballon. Un ballon de football présente parfois des pentagones noirs, ce qui n’est jamais le cas d’un crâne rasé. Un ballon entre parfois en collision avec un pied, ce qui n’est, espérons-le, que très rarement le cas d’un crâne !

Cette erreur n’est donc pas inhérente au deep learning : elle est due au fait que le modèle n’a pas vu suffisamment de crânes rasés pour apprendre à les distinguer des ballons de football, et aurait pu être évitée avec un jeu de données plus adéquat.

L’algorithme de reconnaissance faciale d’Amazon est très performant… sauf pour les personnes racisées

En 2016, Amazon Web Services commercialise Rekognition, son outil de reconnaissance faciale, à plusieurs agences des forces de l’ordre aux Etats-Unis.

En 2018, suite à plusieurs controverses sur la précision de cet outil, l’American Civil Liberties Union (l’ACLU, une organisation à but non lucratif américaine) réalise des tests : les photographies des 533 membres du Congrès des États-Unis sont comparés à une base de données composée de 25 000 images de personnes ayant été arrêtées.

Première surprise, 28 membres du Congrès sont identifiés comme correspondant à une de ces personnes, soit un taux d’erreur de plus de 5%.

Pire, parmi ces 28 erreurs, 39% (soit 11 personnes) sont des personnes racisées, alors qu’elles ne représentent que 20 % de l’ensemble des membres du Congrès. Le taux d’erreur de Rekognition sur ces personnes est donc de plus de 10%.

Ces résultats confirment ceux d’une étude académique publiée (en anglais) la même année, et démontrant que les algorithmes de reconnaissance faciale sont moins fiables pour les personnes racisées que pour les personnes non racisées, et moins fiables pour les femmes racisées que pour toute autre catégorie de personnes.

Comme pour le crâne de l’arbitre confondu avec le ballon de football de l’exemple précédent, ceci signifie que ces modèles ont été entraînés avec des jeux de données insuffisamment variés.

Rappelons qu’au moment de la publication de ces résultats, Rekognition (ainsi que d’autres logiciels de reconnaissance faciale commercialisés par Microsoft et IBM) était déjà utilisé depuis deux ans par les forces de l’ordre de plusieurs villes aux Etats-Unis.

Autrement dit, ces entreprises ont mis ces modèles sur le marché, et les autorités les ont utilisés, sans que quiconque n’ait vérifié sérieusement leurs performances.

Suite aux nombreuses controverses, Amazon, Microsoft et IBM ont interdit – d’abord temporairement, puis de manière plus durable – l’achat de leur logiciel pour les départements de police.

Cet exemple illustre à quel point il est indispensable de tester les modèles de manière exhaustive avant de les mettre sur le marché.

Les modèles de classification amplifient le biais présent dans les données d’entraînement

Les modèles de deep learning sont entraînés sur de grands jeux de données. Il est difficile de constituer un jeu adéquat : il doit contenir énormément d’images, celles-ci doivent être variées, et les annotations associées doivent être fiables. Les annotations représentent la « vérité terrain » que le modèle cherche à retrouver.

Pour cette raison, il est courant d’entraîner des modèles sur des jeux de données publics. C’est d’ailleurs à la publication du premier jeu public de très grande envergure, ImageNet, qu’est souvent attribué l’essor du deep learning.

Ces dernières années, des inquiétudes ont émergé au sujet de ces jeux de données publics. Etaient-ils suffisamment variés ? Dans le cas contraire, leur utilisation risquait de donner des modèles aux performances dégradées pour certaines catégories, comme les modèles de reconnaissance de visage ou le modèle de suivi de ballon de football décrits dans les paragraphes précédents. Présentaient-ils d’autres biais, pouvant affecter la précision des modèles les utilisant ?

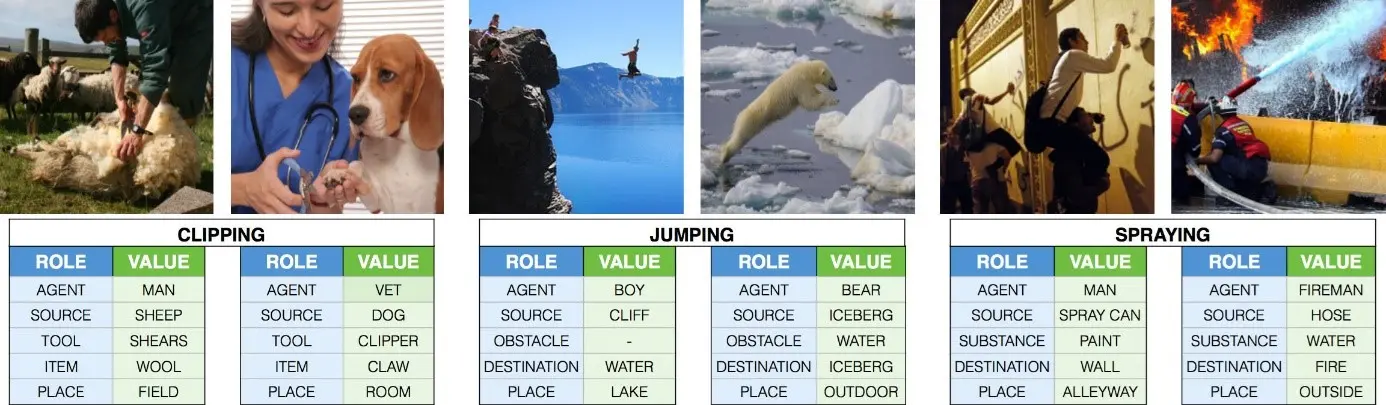

C’est dans ce contexte qu’en 2017, un groupe de chercheuses et chercheurs publie un article étudiant les biais de genre dans plusieurs jeux de données couramment utilisés, et l’effet de ces biais sur les modèles.

Pour cela, deux jeux de données ont été étudiés.

Le premier, imSitu, est un ensemble de plus de 120 000 images, chacune associée à une description de l’activité représentée dans l’image. Il est utilisé pour entraîner des modèles pouvant décrire en détail l’activité représentée dans une image.

Le second, MS-COCO, contient 328 000 images, chacune associée au contour des objets présents dans cette image. Il est utilisé pour l’entraînement de modèles de classification et de segmentation.

Cet article a démontré qu’une grande proportion des activités et objets présents dans ces deux jeux de données est fortement liée à un genre plutôt qu’à un autre.

Ainsi, les images liées aux activités « cuisiner », « laver » et « faire les courses » dans imSitu représentent très majoritairement des femmes. Les activités « conduire », « tirer un coup de fusil » et « mener » représentent très majoritairement des hommes. De plus, la majorité des images représentent des hommes.

Les images de MS-COCO représentent elles aussi majoritairement des hommes. Et, comme les activités dans imSitu, plusieurs objets sont fortement liés à un genre plutôt qu’un autre. Les objets utilisés en cuisine, comme « couteau », « fourchette », et « cuillère », sont plus fréquemment associés à des femmes. Les objets de loisir, comme « raquette de tennis », « bateau », ou « snowboard », sont majoritairement associés à des hommes.

Plus grave encore, cette étude a montré que ces biais étaient amplifiés par les modèles.

Ainsi, un modèle entraîné sur imSitu prédit plus fréquemment qu’une personne en train de cuisiner est une femme, plutôt qu’un homme. Dans les données d’entraînement, en effet, il y a 33% plus de femmes que d’hommes dans des images relatives à la cuisine. Cependant, le modèle prédit 68% plus fréquemment que cette personne est une femme plutôt qu’un homme.

Pendant l’entraînement, les modèles de deep learning s’appuient généralement sur le contexte pour améliorer leur prédiction moyenne. Pour détecter si une personne est un homme ou une femme, par exemple, si le visage est trop petit dans l’image, alors regarder les objets placés autour de la personne est certainement plus fiable. C’est ainsi que les biais présents dans les images sont non seulement propagés, mais amplifiés, dans les modèles entraînés.

Cette amplification des biais a été retrouvée pour toutes les activités et tous les objets des deux jeux de données.

Ainsi, si vous entraînez un modèle sur un jeu de données public, votre modèle souffrira très probablement de biais. Il vous appartient donc de tester ses performances de manière exhaustive, afin de vérifier si ce biais est problématique pour votre application.

Si vous voulez en savoir plus sur le sujet, consultez le dernier livre de Daphné Wallach

Disponible également dans la Bibliothèque Numérique pour les professionnels.

Diplômée d’un doctorat en intelligence artificielle pour le traitement d’images médicales, Daphné Wallach exerce depuis plus de 10 ans dans ce domaine. Elle est ingénieure en recherche et développement dans la start-up Intradys, qui développe des outils d’intelligence artificielle pour la neuroradiologie interventionnelle. Elle met également son expertise au bénéfice de formations sur l’intelligence artificielle et sur le traitement d’images, qu’elle dispense à l’université de Rennes et en entreprise.