Référencement : optimiser la visibilité SEO d’un site internet

Introduction : la révolution User eXpérience dans le SEO

Le SEO devient enfin et officiellement SXO

Le SEO est l’acronyme utilisé pour définir le Search Engine Optimisation, que l’on appelle plus simplement le référencement naturel. Mais les dernières évolutions de l’algorithme de Google transforment ce SEO en SXO : le Search Expérience Optimisation, qui est en fait le mariage entre l’UX (la User eXpérience) et le SEO.

L’objectif est simple : que tous les trucs et astuces de référenceur qui, malheureusement, polluent le Web depuis de nombreuses années soient de moins en moins efficaces.

Prenons des exemples : les millions de sites de contenus de très faible qualité et sans intérêt sur lesquels vous tombez très souvent devraient être de plus en plus déclassés dans les années à venir (Google estime que 60 % des contenus web sont de la duplication). Le linking externe, qui a été la « machine à cash » de très nombreux référenceurs, voit son rôle très fortement diminuer et, dorénavant, nous ne devons plus calculer la qualité du linking avec des critères obscurs (ex : Trust Flow/Citation Flow), mais tout simplement en étudiant parmi tous vos liens quelle est la proportion de liens qui vous apportent du trafic (puisque c’est la base de rôle d’un lien !).

Et c’est bien cela que Google entend par une notoriété de qualité.

C’est pour cette raison que, depuis plus de 10 ans, Google lutte pour améliorer la qualité des sites internet en modifiant son algorithme. Les premières grandes modifications permettaient de pénaliser les sites qui ne respectaient pas ses guidelines. Mais, les nouveautés (notamment l’intégration de l’intelligence artificielle et de la User eXpérience comme critères principaux) sont une révolution : le référencement devient ce qu’il aurait toujours dû être, c’est-à-dire du marketing.

Le contenu est l’ingrédient indispensable pour les internautes, mais aussi pour l’optimisation du référencement. La recherche effrénée de backlinks...

Évolution de l’algorithme de Google (en très simplifiée)

L’algorithme de Google évolue en permanence. Toutes ses modifications (plus de 500 par an, au total) sont publiées chaque mois.

Certaines portaient même des noms sympathiques d’animaux au pelage noir et blanc (Panda, Pingouin). Pourquoi ces couleurs ? Elles faisaient référence à ce que nous appelons le White Hat SEO, c’est-à-dire les techniques de référencement approuvées par Google et présentées dans les Google Guidelines. Elles s’opposent au Black Hat SEO, ou les techniques utilisées par de nombreuses sociétés de référencement, mais proscrites par Google, comme l’achat de liens, le linking automatisé par des logiciels de création de liens, etc.

Les évolutions de l’algorithme n’ont qu’un seul objectif : optimiser la pertinence des résultats de recherche pour les internautes et contrer les mauvaises pratiques de nombreux référenceurs.

Voici pour rappel quelques grandes dates

1994 : Yahoo, un annuaire qui nécessite une action de déclaration, est le point de départ des outils de recherche pour les internautes.

1998 : un nouvel acteur arrive, Google, qui est un moteur de recherche et non un annuaire.

1999 : naissance de l’algorithme de Google sous le nom Page Rank (pour rappel, un des deux fondateurs de Google se nomme Larry Page). C’est la formule de départ de Google. Nous sommes dans un Web balbutiant et, pour Google, le simple fait d’avoir un certain nombre de liens qui pointent vers votre site est suffisant pour en déduire une forte notoriété et ainsi vous positionner. C’est le début de la course au lien !

2002 - 2003 : apparition des blogs et donc expansion des techniques de linking.

2010 : acquisition de Meta web, le spécialiste des données sémantiques. C’est le point de départ pour une évolution de l’algorithme de Google.

L’idée est de permettre à Google de comprendre, pour une même requête faite par plusieurs internautes, que les attentes en termes de résultats sont différentes.

Prenons un exemple simple (fourni par Lionel Goube, fondateur de OnCrawl) :

Google comprend les liaisons...

Les fondamentaux de notre philosophie SEO/SXO

Penser positionnement des pages et non-référencement du site

N’oubliez pas que Google ne positionne pas les sites internet, mais les pages des sites internet. De ce fait, vous pouvez disposer de pages extrêmement bien positionnées sur des expressions fortes alors que d’autres pages ne le seront pas du tout. Chaque page doit être pensée comme un mini-site capable de se positionner sur certaines expressions.

Et quand vous étudiez vos positions, pensez surtout à étudier vos pages positionnées et non justes vos mots-clés positionnés (nous sommes toujours étonnés en 2017 de voir des rapports de positionnements fournis aux entreprises n’intégrant pas les URL des pages positionnées).

Penser internaute et non moteur

Ne vous focalisez pas sur le référencement, car ce n’est pas Google qui achète vos produits, mais bien les internautes ! Plus votre site sera optimisé pour simplifier et accompagner l’internaute, meilleur sera votre référencement. Il est d’ailleurs essentiel de maîtriser le vocabulaire utilisé par ceux-ci sur votre thématique.

Prenons un exemple : la requête « pas cher », très à la mode, qui est utilisée dans de nombreux secteurs.

Si la requête « voyage pas cher » est attendue, « crédit pas cher » l’est moins. Il est à supposer dans ce dernier cas que l’internaute recherche un crédit à taux faible : ce qu’il...

Comment cherchent les internautes ?

Il n’y a pas que Google dans la vie (ou presque)

En France, 94 % des recherches sur un moteur de recherche sont effectuées sur Google. Cependant, nous nous devons de vous rappeler qu’il existe d’autres moteurs, qui sont, bien entendu, des alternatives à Google comme moteur de recherche :

-

Bing (qui intègre Yahoo) est toujours là, même s’il représente en Europe moins de 5 % des recherches ;

-

Qwant, un moteur de recherche français lancé en 2013 qui annonce ne pas tracer ses utilisateurs afin de garantir la vie privée et se veut neutre dans l’affichage des résultats (reste à connaître leur futur modèle économique car, dès que la publicité rentre en ligne de compte, la vie privée s’efface).

Il en existe des dizaines d’autres, chacun avec sa spécialité (Ask, Duck Duck Go…).

Mais, certaines plateformes sont devenues des sites « plateformes de recherche » sur lesquels nous cherchons directement :

-

Nous recherchons directement des vidéos sur YouTube ;

-

Nous recherchons sur Amazon tout ce qui est achetable ;

-

Nous recherchons des humains sur Facebook, mais aussi des communautés ;

-

Nous recherchons sur Wikipédia quand nous souhaitons disposer d’une information sérieuse et bien détaillée.

Le premier mot saisi sera considéré par Google comme le plus important lors de la recherche

Si une requête démarre par « Pourquoi », Google sait que ce sera une question. Le premier mot aura donc un poids plus important que les autres dans les résultats, en faisant par exemple remonter dans les premières réponses les pages web où ce mot est dans le titre de la page. Ce point peut avoir un effet très important sur le tri des résultats par Google, en amenant dans les dix premières réponses une page web jusque-là « perdue » au-delà des trente premières réponses.

La longueur moyenne des mots-clés...

Comment faire un état des lieux (audit)

Comment connaître son positionnement ?

Le positionnement correspond à la position des pages de votre site sur des expressions-clés. Le but du référencement est d’obtenir de bonnes positions sur des expressions susceptibles de vous apporter du trafic.

Il est donc nécessaire de disposer d’informations crédibles à ce sujet. La vérification de votre position réalisée sur votre ordinateur n’est plus du tout fiable à cause de la recherche personnalisée (vous aurez le sentiment d’être très bien positionné en vérifiant sur votre ordinateur et beaucoup moins sur d’autres postes). Vous devez donc trouver d’autres méthodes pour vérifier votre positionnement.

Dans un premier temps, savez-vous combien d’expressions vous ont apporté du trafic ces dernières semaines ? Quand nous posons cette question aux responsables de sites internet, ils nous répondent souvent : « 30, 40, 100 expressions... ». Ils découvrent par la suite que ce sont plusieurs centaines, voire plusieurs milliers d’expressions.

Pour le savoir, il fut un temps où nous disposions de cette information dans notre compte Google Analytics.

Voici, par exemple, le nombre d’expressions-clés ayant apporté du trafic pour une petite boutique en ligne :

Nous avions 5469 visites en provenance des moteurs de recherche avec un total de 2708 expressions-clés ayant apporté ce trafic. Cela donne une moyenne de deux visites par expression.

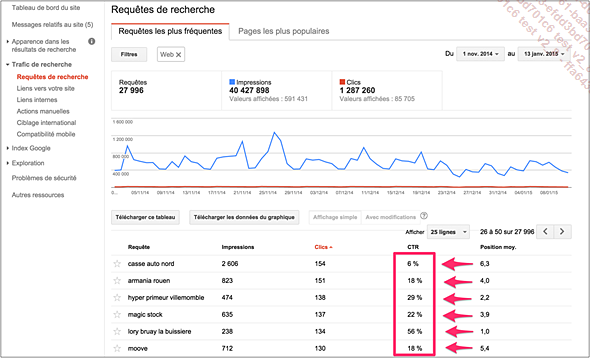

Google Console, un outil gratuit pour connaître son positionnement

Dans votre compte Google Console, cliquez sur Trafic de recherche > Analyse de la recherche.

Vous pouvez ainsi savoir :

-

Sur quelles expressions les pages de votre site ont été visibles dans Google.

-

Le nombre d’impressions (nombre de fois où une page de votre site a été présente dans un résultat de recherche) et le nombre de clics.

-

Et surtout, votre position moyenne (celle-ci varie en permanence, notamment à cause de la recherche personnalisée).

Les outils payants d’audit de positionnement

Audit de positionnement : exemple Myposeo

Pour connaître votre positionnement de façon plus précise...

Le SEO c’est avant tout du marketing

Définir ses personas

Le référencement, c’est du marketing ; il est donc essentiel de comprendre la demande et sur Google, la demande se traduit en recherche avec des expressions clés.

Il faut donc identifier et comprendre les internautes : dans le domaine du marketing, et encore plus dans celui du marketing digital, nous utilisons pour cela l’étude des personas.

Le site www.definitions-marketing.com les définit très simplement, mais très efficacement (comme l’ensemble de leurs définitions que nous vous recommandons très fortement) :

« Un persona est, dans le domaine marketing, un personnage imaginaire représentant un groupe ou segment cible dans le cadre du développement d’un nouveau produit ou service ou d’une activité marketing prise dans sa globalité. [...] Plusieurs personas peuvent être utilisées pour un même projet de développement ».

L’objectif est ainsi de mieux connaître ses audiences et de ne pas passer à côté de ses attentes. Cela permet de réunir suffisamment d’informations sur un groupe cible pour dessiner un personnage imaginaire qui deviendra leur représentant officiel. La finalité est de dresser le portrait d’une personne comme nous parlerions de son (sa) meilleur(e) ami(e)...

Bloc 1 : les facteurs de contenus

En nous référant aux dernières évolutions et aux remarques du site Moz, voici les critères de contenus fondamentaux que nous allons ensuite développer :

-

La pertinence thématique et sémantique.

-

Site en SILO avec contenu textuel (lexies).

-

Page, nombre de pages.

-

Nombre de mots par page.

-

Page en plan de dissertation.

-

Balises Title, Description et H1, mots-clés dans Body, mots-clés dans Titre, Contenu média.

-

Nombre d’images, référencement image.

-

Intégration vidéo.

-

Référencement vidéo sur YouTube, Type PPT intégration (exemple : Slideshare).

Un site, ce sont des expressions clés

La grande question : se positionner, oui, mais sur quoi ?

Le constat que nous faisons souvent quand nous découvrons un site internet qui souhaite nos conseils pour l’optimisation de son référencement est la faible intersection entre leurs contenus rédactionnels et les typologies de requêtes de leur cible.

Ce qui serait beaucoup mieux :

Le contenu doit être optimisé en priorité pour les internautes. Nous devons employer une sémantique équivalente à celle de nos cibles et cela est rarement le cas. Les pages sont souvent rédigées dans un langage trop technique et trop professionnel, ce qui est un frein pour le référencement. Nous ne souhaitons en aucun cas vous expliquer qu’il faut rédiger vos sites dans un français approximatif, mais il faut le rédiger avec une sémantique plus proche de celle des internautes.

Analyser ses contenus actuels

Si vous souhaitez avoir une idée concrète des expressions fortes associées à votre site, vous pouvez utiliser le logiciel Screaming Frog SEO Spider. Comme vu précédemment, vous vous rendrez compte, en un seul coup d’œil, de la qualité ou non de vos balises (Title, H1, H2, Meta Description).

N’hésitez pas à imprimer le contenu textuel de vos pages afin de les étudier un par un, et de vous concentrer ainsi sur leur rédaction.

Analyser ses campagnes AdWords si elles existent

Google AdWords est l’outil qui vous apportera les informations les plus sûres. Vous pouvez créer des campagnes « génériques...

Bloc 2 : les facteurs techniques

-

Structure indexable.

-

CMS.

-

Présence de H1/H2.

-

HTTPS.

-

Nom de domaine.

-

Ancienneté du domaine.

-

Classement TLD (extension domaine).

-

Taille du fichier (Ratio contenu/code).

-

Vitesse du site.

-

Longueur de l’URL - Lisibilité de l’URL.

La structure du site doit être indexée par le moteur

Pour cela, le langage utilisé pour la construction des pages doit être en HTML. Le site doit avoir une structure « lisible » par les moteurs. Par exemple, un site réalisé en Flash ne sera pas référencé par Google puisque les contenus des sites dits « Full Flash » (réalisés à 100 % en Flash) ne sont pas lus par Google. Matt Cutts, un des principaux responsables de Google a écrit : « Nous travaillons sur les systèmes comme Flash, mais il n’y aura jamais mieux qu’un site HTML ». Un site 100 % Flash n’est pas indexable par Google, car il n’identifie qu’une seule page vide !

Contraintes, obstacles et freins au référencement

Le référencement et l’optimisation potentielle du positionnement se pensent dès la rédaction du cahier des charges, des choix techniques ainsi que du logiciel CMS (Content Management System) utilisés.

Il faut penser, le cas échéant, aux possibilités de modifier les balises Title, d’insérer des balises H1 et de réécrire des adresses URL (cf. section Choix du CMS). L’idéal est de créer des sites avec des logiciels CMS connus et renommés (Open Source), car ils sont souvent mis à jour. Il faut donc être vigilant face aux agences qui proposent leurs propres outils ou logiciels CMS.

Les sites avec plus d’images que de texte

Google ne lit pas le contenu des images, ce qui signifie que les pages contenant uniquement des images ne seront pas indexées. De plus, les visuels réduisent la vitesse de chargement des pages ; or, un certain temps de « crawl » est alloué au cours de la visite de vos pages par les robots de Google. Plus vos pages mettront du temps à s’afficher, moins Google pourra indexer vos données. Pour vérifier que vos pages s’affichent rapidement, nous vous...

Bloc 3 : les signaux sociaux

Ce bloc est l’un des changements fondamentaux dans l’algorithme. Le linking, qui fut au début de Google le point le plus important, mais également le plus décrié, est maintenant un critère parmi d’autres. Nous allons développer dans cette partie les 2 fondamentaux qui mettent en avant la notoriété au sens algorithmique de Google.

Backlinks & « linking externe »

Mise en garde

Le « linking externe » fut le premier pilier de l’algorithme lors du lancement de Google en 1998.

Il correspondait parfaitement à ses critères de qualité : si un grand nombre de liens pointent vers un site, cela représentait le gage d’une bonne notoriété et, par extension, d’une qualité élevée. Pour rappel, le Web était balbutiant ; le premier site internet venait d’apparaître 5 ans auparavant. Personne en 1998 ne pouvait prévoir l’expansion de l’influence du digital dans le monde en quelques années. Personne n’avait été formé et nous étions dans le royaume de la débrouille et des autodidactes.

Malheureusement, au regard des enjeux liés à la position des sites dans les premiers résultats de Google, est né un business mondial du linking externe : apparition d’usines à liens, démultiplication de millions d’annuaires, etc.

Google a donc décidé, en 2010, de reformuler son algorithme afin de proscrire ces pratiques de telle sorte qu’aujourd’hui, il est obligatoire de travailler le « linking externe » de façon qualitative.

L’idéal serait de ne pas faire de liens, mais de créer des contenus à forte valeur ajoutée afin que ce soit les internautes qui vous recommandent par l’intermédiaire de liens. Nous recommandons et appliquons cette méthode à l’ensemble de nos clients.

Toutefois, il faut reconnaître que cela est complexe à mettre en place. Nous vous proposons donc une méthodologie complète de développement de votre linking externe par ordre de priorité.

Elle s’appuie sur une règle très simple : pensez en priorité au trafic...

Bloc 4 : les signaux utilisateurs

C’est l’évolution fondamentale, notamment due à l’intégration de Rank Brain dans l’algorithme de Google. Avant, Google se contentait d’analyser les sites ; maintenant, il va enfin tenir compte de l’usage qui est fait des sites par les internautes, c’est-à-dire l’expérience utilisateur. C’est un critère qualitatif qui sera beaucoup plus compliqué à optimiser pour les référenceurs non marketeurs. Cela signe en fait un peu la fin du référencement SEO pour l’amener sur ce que l’on appelle maintenant le SXO, comme nous l’avons étudié au début de ce chapitre.

Expérience utilisateur - ergonomie navigation

Voici les principaux facteurs :

-

Taux de clics (CTR) dans les résultats.

-

Taux de rebond par page.

-

Pogosticking.

-

Taille de police.

-

Nombre de liens internes cliqués.

-

Analyse du nombre de pages vues.

-

Analyse du temps passé.

-

Facilité de navigation avec un fil d’Ariane.

-

Éléments interactifs (et donc des interactions).

-

Présence de listes à puce, de contenus structurés et de contenus rédigés.

-

Mais peu de publicité.

Taux de clics (CTR) dans les résultats

Il correspond au nombre de clics sur le nombre d’impressions que vous aurez eu lors des recherches dans Google. Il est facile pour vous d’identifier vos CTR, tout simplement en regardant vos statistiques dans Google Console. Si Google détecte qu’un résultat (une page dans les résultats de Google que l’on appelle aussi les SERP) a un CTR bien supérieur à ceux de votre concurrence, alors il en déduira que les internautes sont attirés par ce que vous proposez. Votre résultat obtiendra alors de meilleures positions, et inversement pour vos concurrents. De plus, et en toute logique, si vous optimisez votre positionnement, vous optimiserez votre taux de clics puisque les taux de clics sont beaucoup plus importants pour les tops positions. Les statistiques donnent en moyenne un taux de clic 15 fois supérieur entre la 10ème et la 1ère place, et 8 fois supérieur entre la 5ème et la 1ère place.

Mais, ce qui permet un CTR élevé ce sont :

-

Votre balise Title, qui doit être simple...

Editions ENI Livres | Vidéos | e-Formations

Editions ENI Livres | Vidéos | e-Formations