Comprendre et expliquer un modèle

Explicabilité

1. Motivation

Les arbres de décision, quand ils sont entraînés à l’aide de la méthode de Gradient Boosting, peuvent atteindre des niveaux de performance très élevés.

Sur des données tabulaires en particulier, ils n’ont rien à envier aux approches de type Deep Learning. Ils arrivent régulièrement en tête de nombreux concours de Data Science et sont légion à être déployés dans des applications de Machine Learning. Ils présentent le net avantage, par rapport aux approches neuronales, d’un temps d’entraînement plus court et d’une plus grande facilité de configuration.

Ce niveau de performance ne vient pas sans un revers, qu’ils partagent d’ailleurs avec les méthodes de Deep Learning : ils souffrent de l’effet boîte noire. Il est difficile, dès que les modèles générés contiennent plusieurs arbres, de comprendre le rôle des features en entrée sur les prédictions générées.

Or, comprendre l’importance, le poids et le sens de l’effet de chaque feature en entrée sur la prédiction en sortie est crucial pour au moins trois raisons.

Premièrement, cette compréhension est un guide précieux pour le Data Scientist. Elle le renseigne...

Feature importances

1. Présentation

La méthode la plus utilisée et disponible en standard pour les trois implémentations XGBoost, CatBoost et LightGBM est celle de la feature importance. Elle attribue à chaque feature un poids donnant une idée de son importance au global.

Ce n‘est donc pas une méthode qui permet une vue locale, à la résolution de la prédiction.

Plusieurs manières de calculer ces poids sont envisageables, suivant que le focus est mis sur les gains, les poids ou d’autres indicateurs tels que la couverture.

2. Calcul basé sur le niveau d’utilisation

Selon ce mode de calcul, le poids est donné pour chaque feature par le nombre de fois où cette dernière se trouve impliquée au niveau d’un nœud, pour séparer les données en deux sous-ensembles. Ce mode est nommé mode weight.

Cela donne une idée d’à quel point la feature est utilisée pour garantir un bon niveau de prédiction. Cela implique généralement une plage de valeurs étendue pour cette feature, puisque la méthode de Gradient Boosting a trouvé pertinent de la découper en de nombreuses plages de valeurs différentes.

Cette dépendance à la cardinalité de la feature peut introduire un biais dans l’explicabilité, dans la mesure où une feature avec une large cardinalité a de fortes chances de se retrouver utilisée dans de nombreux nœuds.

3. Calcul basé sur les gains

Dans ce mode de calcul, nommé gain, le poids est calculé en moyennant les gains obtenus lorsque la feature considérée a été utilisée comme critère de séparation de l’ensemble de données.

Cela donne donc pour chaque feature une idée moyenne de l’impact de cette feature sur la réduction de l’erreur. L’avantage de ce mode de calcul est qu’il donne une idée précise de l’apport de la feature en termes de gain apporté au modèle, indépendamment du nombre de fois où elle est utilisée.

4. Calcul basé sur la couverture

La dernière classe de mode de calcul de la feature importance se base sur la couverture, c’est-à-dire...

SHAP : SHapley Additive exPlanation

La section précédente a présenté les feature importances, qui apportent un éclairage quantitatif sur le rôle de chaque feature, aussi bien dans la construction du modèle que dans la prédiction. Leur valeur explicative reste néanmoins cantonnée à une vue globale.

Dans cette section, la méthode SHAP, Shapley Additive exPlanation, va être présentée. Elle permet une compréhension plus fine d’un modèle, en autorisant de descendre au niveau de la prédiction. C’est une méthode récente, qui a été publiée pour la première fois en 2016.

Elle offre en outre une vue plus fine, en détaillant de manière quantitative et signée l’impact de chaque feature. Cela signifie qu’elle informe sur la direction dans laquelle la prédiction a été tirée : à la hausse ou à la baisse. C’est un éclairage très important sur le fonctionnement du modèle.

Enfin, c’est une méthode générique qui s’applique à n’importe quel type de modèle, du réseau de neurones profond aux SVM, en passant bien sûr par les arbres de décision.

1. Objectif : construire un modèle explicatif

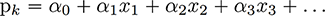

Dans le cas où un modèle linéaire est utilisé pour réaliser une prédiction, cette dernière se calcule avec la formule suivante :

La prédiction est alors une combinaison linéaire de chacune des features x_i. Le poids d’une feature i dans la prédiction k est donc le produit du ième coefficient alpha avec la valeur de la ième feature.

Un tel modèle embarque directement un modèle explicatif de type additif, puisque la prédiction est la somme de chaque poids multiplié par chaque feature. Si le coefficient est positif, alors la feature influe sur la prédiction à la hausse. S’il est négatif, la prédiction est tirée vers le bas. La valeur absolue du produit de la feature par le coefficient donne l’importance de cette feature au sens de Shapley.

Editions ENI Livres | Vidéos | e-Formations

Editions ENI Livres | Vidéos | e-Formations