La place du cloud et de l’IA au sein d’un SOC

Introduction

1. Une transformation structurelle du paysage IT

Depuis une dizaine d’années, le monde informatique traverse une mutation aussi rapide que profonde. Si les premières décennies de l’informatique d’entreprise ont été rythmées par l’achat de serveurs physiques, l’installation locale de logiciels et la gestion sur site des infrastructures, les années 2010 ont progressivement basculé vers un modèle où l’IT devient un service à la demande : plus flexible, plus modulaire, mais aussi plus complexe à maîtriser.

Le SOC, en tant que structure opérationnelle dédiée à la supervision et à la réponse aux incidents de sécurité, n’échappe pas à cette tendance. Il en est même l’un des témoins les plus sensibles, car il doit non seulement surveiller cette nouvelle architecture hybride ou externalisée, mais aussi s’y adapter dans son propre fonctionnement.

Le cloud et l’intelligence artificielle sont aujourd’hui deux des leviers principaux de transformation du SOC. Le premier en redéfinit l’architecture technique et les modalités de déploiement ; le second en bouleverse les capacités d’analyse, de traitement et d’automatisation.

Ensemble, ils dessinent les contours d’un...

L’évolution vers le cloud

1. Rappel historique : du serveur physique au cloud

a. Les serveurs physiques

L’histoire de l’informatique moderne est intimement liée à l’évolution de l’infrastructure matérielle. Dans les années 2000, les entreprises s’appuyaient presque exclusivement sur des serveurs physiques installés dans leurs locaux (on-premise). Chaque serveur était généralement dédié à une application ou à un service spécifique : base de données, serveur mail, Active Directory, etc. Cette approche avait l’avantage de la maîtrise locale, mais présentait de nombreuses limites : occupation d’espace, coûts élevés d’acquisition et de maintenance, surdimensionnement fréquent pour anticiper les pics de charge, faible flexibilité, et une faible résilience en cas de panne matérielle.

b. Les machines virtuelles

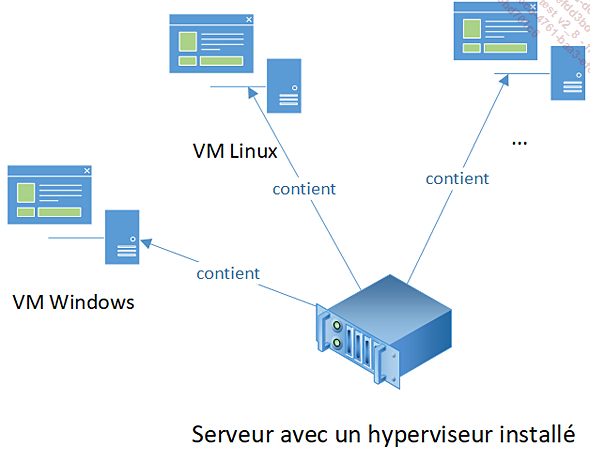

Avec l’essor des besoins métiers est apparue une première révolution : la virtualisation. Grâce à l’introduction d’un hyperviseur - une couche logicielle entre le matériel et les systèmes d’exploitation - il devenait possible d’héberger plusieurs machines virtuelles (VM) sur un seul serveur physique. Chaque VM pouvait simuler un serveur indépendant, avec son propre système d’exploitation, ses ressources (CPU, RAM, disque) et ses services.

Cette approche apporta des bénéfices majeurs :

-

Optimisation des ressources : un serveur physique pouvait héberger plusieurs VM, réduisant la sous-utilisation matérielle.

-

Flexibilité : il devenait possible d’ajuster facilement les caractéristiques d’une VM (ajouter de la RAM, allouer plus de CPU…).

-

Snapshot et sauvegarde : les snapshots permettaient de capturer l’état complet d’une machine à un instant T, facilitant le retour arrière après une mise à jour ou une opération risquée.

-

Provisionnement rapide : créer une nouvelle VM ne prenait plus que quelques minutes, contre plusieurs heures (ou jours selon la livraison matérielle) auparavant pour une machine physique.

-

Isolation logique :...

Le modèle hybride : entre cloud et on-premise

1. Pourquoi le « tout cloud » n’est pas toujours possible

Si le cloud public est souvent présenté comme une solution miracle - flexible, économique, et rapide à déployer - la réalité opérationnelle impose des limites concrètes à son adoption totale. L’idée d’un SOC intégralement hébergé dans le cloud, bien qu’attirante sur le papier, se heurte à une série d’obstacles techniques, organisationnels, réglementaires, et humains.

a. Contraintes réglementaires et souveraineté des données

Comme évoqué précédemment, de nombreux secteurs sont soumis à des contraintes réglementaires très strictes. La localisation des données y est un sujet critique : les logs, les identités ou les incidents doivent être stockés dans des zones géographiques spécifiques, voire au sein de structures contrôlées par des entités nationales. Dans ce contexte, faire appel à un fournisseur cloud américain ou international, même via une région « France », soulève des problématiques de conformité : lois extraterritoriales, absence de garanties sur la chaîne de sous-traitance, impossibilité d’auditer le fournisseur, etc.

b. Dépendances techniques : capteurs, enclaves, réseaux

Même lorsque la conformité est assurée, d’autres obstacles subsistent : les éléments supervisés ne sont pas nécessairement « cloud ready ». Certains équipements (systèmes industriels, équipements réseau, vieilles applications métiers, bases de données internes) ne peuvent pas être exposés à Internet ou ne disposent d’aucune compatibilité avec les architectures cloud modernes. Ils nécessitent une collecte de logs ou de métriques locales, des sondes déployées sur site, voire une interconnexion...

Cloud et SOC as a Service : la nouvelle norme

1. Du cloud au SOCaaS : une rupture organisationnelle

L’arrivée du cloud n’a pas simplement modifié la manière dont les entreprises consomment des ressources informatiques : elle a profondément transformé la façon même dont les services de cybersécurité sont conçus, structurés, livrés et opérés. Parmi les bouleversements induits, le modèle du SOC as a Service (ou SOC managé) s’impose aujourd’hui comme l’un des plus marquants.

Dans un monde où la réactivité face aux cybermenaces devient un facteur différenciant, le cloud a permis de faire évoluer le SOC d’un modèle rigide, coûteux et lent à mettre en œuvre vers une approche industrialisée, modulaire et standardisée. Là où l’on parlait autrefois d’équipes internes opérant sur des infrastructures propres, le SOC moderne peut désormais être proposé comme un service prêt à l’emploi, hébergé à distance, mutualisé entre plusieurs clients, mais capable de s’adapter à chacun d’eux.

Le cloud n’est pas ici qu’un simple support technique : il est le socle qui permet cette nouvelle offre de valeur. Il apporte l’élasticité nécessaire pour gérer des centaines de clients, la puissance de calcul pour analyser des flux massifs d’événements, et la standardisation des environnements pour industrialiser les processus. Le SOC as a Service n’est donc pas une simple déclinaison « déportée » d’un SOC traditionnel : c’est une refondation de la chaîne de valeur du SOC, rendue possible par les paradigmes cloud.

L’effet de levier est tel que de nombreux MSSP (Managed Security Services Providers), mais aussi des acteurs plus récents ou plus spécialisés (MDR, SOC « moderne »), bâtissent aujourd’hui des offres SOC entièrement centrées sur le cloud. L’organisation même du service évolue : mutualisation des plateformes SIEM/SOAR, automatisation poussée des workflows, tableaux...

L’intelligence artificielle au service du SOC

1. De l’UEBA à l’IA générative : une évolution rapide

L’intelligence artificielle s’est progressivement imposée comme un levier technologique majeur dans de nombreux domaines, et la cybersécurité n’échappe pas à cette dynamique. Dans les SOC, son intégration ne s’est pas faite d’un seul coup, mais par étapes, en commençant par des approches statistiques et comportementales, pour aboutir aujourd’hui à des modèles beaucoup plus complexes et autonomes. Cette évolution mérite d’être analysée en détail, car elle modifie en profondeur les capacités d’un SOC.

a. Les prémices : corrélation simple et règles statiques

Avant même de parler d’intelligence artificielle, les premiers moteurs de détection s’appuyaient sur des corrélations basiques et des règles déterministes. Ces règles permettaient de détecter des comportements définis à l’avance : un trop grand nombre d’échecs de connexion sur un même compte, un flux réseau anormal vers l’extérieur, ou une exécution d’outil connu d’un pentester.

Si ces mécanismes avaient le mérite d’être compréhensibles et auditables, ils souffraient de plusieurs limitations : rigidité, incapacité à détecter l’inconnu, grande sensibilité aux faux positifs et besoin constant de mise à jour manuelle.

b. L’UEBA : premiers pas vers l’analyse comportementale

C’est pour pallier ces limites qu’ont émergé les solutions d’UEBA (User and Entity Behavior Analytics). L’UEBA repose sur l’idée qu’un utilisateur ou une machine a des comportements “normaux” et que toute déviation significative doit être considérée comme suspecte. Il ne s’agit plus ici de déclencher une alerte sur un événement unique, mais d’analyser des séquences d’actions dans le temps et d’en inférer des anomalies.

Concrètement, cela signifie que le SOC peut repérer qu’un utilisateur...

Risques, défis et responsabilités face à l’IA

1. Confidentialité des données manipulées par des IA

L’un des risques majeurs liés à l’introduction de l’intelligence artificielle dans les outils du SOC est celui de la confidentialité des données. En effet, l’efficacité des algorithmes repose très souvent sur l’analyse de vastes volumes de données contextuelles et parfois sensibles : contenus d’e-mails, fichiers suspects, métadonnées réseau, logs d’accès utilisateurs, rapports d’incidents passés, etc.

Or, dans un contexte de cybersécurité, ces données peuvent contenir :

-

des informations à caractère personnel (identité, poste occupé, activités en ligne) ;

-

des secrets industriels (documents confidentiels, schémas réseau, configurations internes) ;

-

des preuves d’attaques en cours (indicateurs de compromission, accès non autorisés).

L’intégration de ces données dans des modèles IA, notamment lorsqu’ils sont fournis en mode SaaS ou dans le cloud, soulève donc des questions éthiques et réglementaires :

Où sont stockées ces données ?

-

Peuvent-elles être utilisées pour entraîner d’autres modèles sans l’accord de l’organisation ?

-

Quelles garanties offrent les éditeurs sur la non-rétention, la pseudonymisation ou la suppression des données après usage ?

-

Les données sont-elles chiffrées au repos, en transit, voire pendant traitement (confidential computing) ?

Des réglementations comme le RGPD en Europe ou le CCPA en Californie imposent des garde-fous stricts. Les entreprises doivent donc intégrer dans leurs processus de due diligence des critères clairs de gouvernance de la donnée : auditabilité, maîtrise des flux, politique de conservation, et clauses contractuelles associées.

Certains acteurs commencent à proposer des IA entraînées localement ou exécutées en environnement cloisonné (on-premise ou air-gapped), afin de répondre à ces exigences.

Enfin, la simple consultation d’un...

Vers un SOC « augmenté » par le cloud et l’IA

1. Une mutation progressive et inévitable

L’ensemble des transformations évoquées jusqu’ici (évolution vers le cloud, démocratisation de l’IA) ne constituent pas des tendances éphémères. Elles traduisent une mutation structurelle du modèle SOC, qui s’opère progressivement, mais de manière inévitable.

Ce nouveau SOC se distingue de ses prédécesseurs par plusieurs caractéristiques :

-

L’automatisation massive des tâches à faible valeur ajoutée : enrichissement d’alertes, dédoublonnage, affectation, exécution de playbooks.

-

L’unification des sources de données, grâce au cloud, aux agents multifonctions, et aux plateformes XDR.

-

La capacité de traitement augmentée, permise par les infrastructures cloud-native, sans contrainte matérielle ou goulot d’étranglement.

-

L’intégration fluide de l’IA, à tous les niveaux : détection, investigation, remédiation, documentation.

Cette mutation n’est pas toujours visible du premier coup d’œil. Elle ne passe pas nécessairement par un remplacement brutal des outils historiques ou des équipes existantes. Elle s’opère souvent par couches successives, avec l’introduction ponctuelle d’un outil plus intelligent, le déploiement progressif de nouvelles fonctionnalités, ou l’externalisation de certaines briques vers des services managés dans le cloud.

Loin d’une rupture frontale, il s’agit d’un réalignement progressif du SOC sur les nouvelles exigences métier :

-

réduction du Time-to-Response ;

-

fiabilisation de la détection ;

-

capacité à monter en charge rapidement ;

-

conformité...

Editions ENI Livres | Vidéos | e-Formations

Editions ENI Livres | Vidéos | e-Formations