Infrastructure de sauvegarde

De multiples objectifs

À l’instar du système d’information de l’entreprise, reposant sur une infrastructure dite locale (On Premise), dans le nuage (Cloud) ou encore hybride (une combinaison des deux), il est nécessaire de définir une infrastructure de sauvegarde adaptée aux contraintes et exigences de l’entreprise. Celle-ci devra être à même de collecter les données afin de les protéger, tout en garantissant une parfaite isolation entre les données de sauvegarde et celles de la production.

L’infrastructure de sauvegarde doit être conçue de façon à fournir une haute qualité de service, car elle est la pierre angulaire de la politique de protection des données de l’entreprise.

1. Stockage primaire et stockage secondaire

Afin de mieux appréhender le principe d’isolation il convient de faire la différence entre ces deux types de stockage.

a. Le stockage primaire au cœur de l’hébergement des données

Les supports physiques destinés au stockage des données de production ou dites actives sont des disques durs, à mémoire de masse magnétique, disposant d’interfaces SAS ou SATA. Néanmoins, depuis la fin des années 2000, les disques SSD viennent progressivement remplacer les disques classiques, notamment au niveau des postes de travail.

De nouvelles interfaces mSATA, puis M.2 connue également sous l’acronyme NGFF (Next Generation Form Factor), viennent progressivement lever les limitations en termes de bande passante des anciennes interfaces. Ainsi, les serveurs s’équipent progressivement de disques M.2 SATA et M.2 nVME. Stimulés par une baisse constante des coûts de fabrication, les disques M.2 nvME s’invitent également dans de nouvelles baies de réseau de stockage (SAN) ou de stockage en réseau (NAS) afin d’accéder aux données de production à des vitesses croissantes.

Le stockage primaire désigne tout support informatique non volatile contenant la donnée de production ou dite active.

b. Le stockage secondaire au service de la protection des données

Les supports physiques destinés au stockage des copies des données de production ou copies de sauvegarde sont plus...

Introduction aux performances

L’accroissement des volumes de données, la réduction progressive des fenêtres de sauvegarde ou encore la diminution du DMIA sont autant de difficultés supplémentaires que la sauvegarde doit surmonter. Par ailleurs, les trois mécanismes intrinsèques d’une opération de sauvegarde mettent en lumière son interdépendance avec les différents équipements serveur, réseau et stockage inhérents à l’infrastructure informatique de l’entreprise. Les lenteurs observées parfois au niveau de certaines tâches de sauvegarde nécessitent d’en identifier les causes profondes avant même de jeter l’opprobre sur la technologie de sauvegarde. Les performances nécessitent une attention particulière dans la mise en œuvre d’une architecture de sauvegarde.

Un dimensionnement incorrect de la solution ou de mauvais choix technologiques ont pour conséquences directes le non-respect des métriques techniques telles que la PDMA et le DMIA.

1. Les goulots d’étranglement

Toute technologie de protection de données est assujettie aux goulots d’étranglement. Quand il s’agit d’une tâche de sauvegarde, un très faible débit en lecture des données ne signifie pas forcément que la solution de sauvegarde est peu performante. Il est indispensable d’identifier et d’analyser le chemin de sauvegarde des données (Backup Data Path), depuis le lieu de collecte jusqu’au lieu de stockage. Afin de mieux comprendre les limitations induites lors de chaque opération élémentaire, une connaissance des performances théoriques et pratiques des différents éléments s’impose.

Les questions à se poser sont relativement simples :

-

Quelle est la vitesse maximale de lecture des données durant l’opération de collecte ?

-

Quel est le débit maximal possible pour transférer les données ?

-

Quelle est la vitesse maximale d’écriture des données durant l’opération de stockage ?

À chacune de ces questions, une mesure doit être réalisée. Le débit minimum obtenu, autrement dit le goulot d’étranglement...

Architectures de sauvegarde

Les métriques techniques telles que la PDMA, le DMIA et la fenêtre de sauvegarde influencent grandement le choix d’une architecture plutôt qu’une autre. Comme cela a été énoncé, une estimation des performances est nécessaire dans la mise en place du projet de solution de sauvegarde. À l’issue de ces estimations et calculs portant sur les trois phases élémentaires, à savoir la collecte, le transfert et le stockage, le goulot d’étranglement doit être clairement identifié.

S’il s’avère souvent difficile d’optimiser les débits de lecture et d’écriture d’une tâche de sauvegarde, ceux-ci étant liés à des limitations d’ordre matériel, il demeure néanmoins possible d’améliorer sensiblement la phase de transfert en choisissant une architecture visant à ne pas transférer les données par le réseau local, par exemple. L’architecture n’a pas non plus vocation à être monolithique en s’appliquant globalement à tous les clients de sauvegarde. Le choix d’une architecture peut donc se faire au cas par cas afin de répondre favorablement aux exigences des métriques techniques définies en amont du projet.

Les différentes architectures disponibles sont les suivantes :

-

sauvegarde réseau (LAN-based backup) ;

-

sauvegarde hors réseau (LAN-free backup) ;

-

sauvegarde NDMP (NDMP-based backup) ;

-

sauvegarde hors hôte (Off-host backup) ;

-

sauvegarde sans agent (Host-based backup).

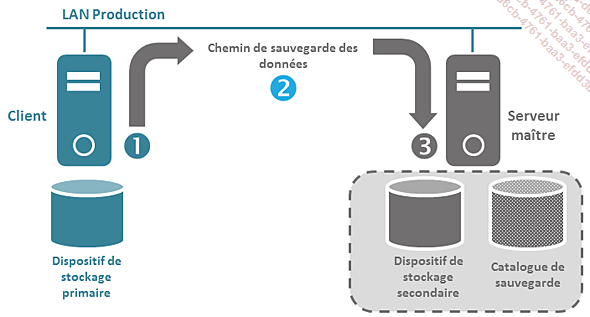

1. Sauvegarde réseau

Cette architecture est historique, elle bénéficie néanmoins toujours d’une large adoption. Sa simplicité d’intégration au sein de l’entreprise en est la principale raison. Il est possible d’implémenter cette architecture selon deux variantes distinctes. La première est illustrée dans le schéma qui suit. Le réseau local de production est ici utilisé pour sauvegarder les données. Un client est installé sur chaque serveur à sauvegarder et le transfert des données de sauvegarde se réalise au moyen du réseau local.

L’alternative possible...

Types de sauvegarde

Au-delà des différentes architectures possibles et indépendamment de la nature des données, il existe différents types de sauvegarde pour différents résultats.

|

Type de sauvegarde |

Résultat de la sauvegarde |

|

Sauvegarde totale (Full Backup) |

Toutes les données sélectionnées sont sauvegardées. |

|

Sauvegarde incrémentale ou incrémentielle (Incremental Backup) |

Parmi celles sélectionnées, seules les données modifiées ou créées depuis la dernière sauvegarde sont sauvegardées. |

|

Sauvegarde différentielle (Differential Backup) |

Parmi celles sélectionnées, seules les données modifiées ou créées depuis la dernière sauvegarde de niveau inférieur sont sauvegardées. |

|

Sauvegarde totale synthétique (Synthetic Full Backup) |

Une sauvegarde de données totale est reconstruite au moyen d’une précédente sauvegarde totale et d’une ou plusieurs sauvegardes incrémentales. |

Le déclenchement et la combinaison de plusieurs types de sauvegarde n’est pas incompatible mais complémentaire dans l’élaboration d’une politique de sauvegarde. Les combinaisons possibles avec les différents types de sauvegarde sont les suivantes.

1. Sauvegardes totales et incrémentales

Dans l’exemple du schéma ci-après, les deux fichiers A et B sont créés respectivement aux instants t-2 et t-1. Une première sauvegarde totale ST est déclenchée à l’instant t0. Les deux fichiers A et B sont par conséquent sauvegardés. Une copie de sauvegarde des deux fichiers est donc créée et mémorisée par le catalogue. Deux sauvegardes incrémentales SI sont déclenchées avant la modification du fichier A. Aucune donnée n’est donc sauvegardée en l’absence de toute modification de fichier. La sauvegarde incrémentale suivante est déclenchée à l’instant t2. Le fichier A ayant été modifié depuis la dernière sauvegarde totale, exécutée en t0, il est par conséquent sauvegardé. Le catalogue mémorise donc une deuxième copie du fichier...

Modes de sauvegarde

Restaurer les données à l’identique est la finalité de toute sauvegarde. Si de nombreuses technologies de protection de données existent, il n’en demeure pas moins qu’elles doivent garantir, quand elles sont utilisées conjointement avec la sauvegarde, l’intégrité des données protégées.

Sauvegarder des données sans pouvoir en garantir une parfaite intégrité est une perte de temps et d’argent.

Par ailleurs, selon la nature des données à sauvegarder, il convient de choisir le mode de sauvegarde approprié permettant de garantir la restaurabilité des données. Les différents modes de sauvegarde possibles sont les suivants :

-

Sauvegarde à froid (Cold Backup)

-

Sauvegarde à chaud (Hot Backup)

-

Sauvegarde par cliché instantané (Snapshot Backup)

1. Sauvegarde à froid

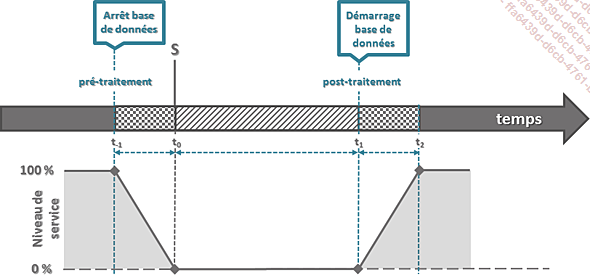

Le déploiement de ce mode de sauvegarde s’applique aux données structurées. La sauvegarde à froid consiste à sauvegarder une base de données lorsque celle-ci est arrêtée. Un script lancé généralement en amont de la tâche de sauvegarde, le pré-traitement, est déclenché afin d’arrêter la base de données. Dans le schéma ci-après, celui-ci démarré à l’instant t-1 pour se terminer en t0. L’arrêt complet de la base de données marque le début de la sauvegarde S à ce même instant. Une fois celle-ci terminée en t1, le script de post-traitement est exécuté dans le but de redémarrer la base de données et de fournir un accès aux utilisateurs. La reprise totale du service débute à l’issue du redémarrage à l’instant t2. Ainsi, la durée d’indisponibilité de la base de données se déroule entre les instants t-1 et t2. Les données sont inaccessibles pour des opérations de lecture ou d’écriture.

Ce mode de sauvegarde a pour avantages d’être simple à mettre en œuvre et de garantir l’intégrité des données en cas de restauration. En revanche, l’indisponibilité provoquée par ce mode de sauvegarde...

Supports de stockage secondaire

Les deux principaux supports de stockage secondaires, utilisés à des fins de stockage des données, font appel aux stratégies de sauvegarde suivantes :

-

Sauvegarde disque vers bande magnétique (Disk-to-Tape - D2T) ;

-

Sauvegarde disque à disque (Disk-to-Disk - D2D) ;

1. Stockage sur bande magnétique

Pendant de nombreuses années, les entreprises ont largement adopté et privilégié la stratégie de stockage sur bande magnétique dans la mise en place de leur politique de sauvegarde. Le coût des disques durs étant prohibitif, la sauvegarde se réalise sur des cartouches physiques. Une cartouche désigne un support de stockage physique contenant une bobine à bande magnétique, utilisée pour stocker tout type de donnée, et pilotée au moyen d’un dispositif électromagnétique.

L’absence de standard en la matière laisse place à la cohabitation de différents formats. On trouve ainsi des cartouches de type DAT/DDS 4 mm et 8 mm, AME Mammoth, DLT, puis SDLT ou encore AIT, pour ne citer qu’elles, avec des capacités native de 20 Go et un facteur de compression de 2:1. À cette époque, Exabyte, IBM, Quantum et Sony sont les principaux acteurs d’un marché proposant pléthore de formats, une faible garantie d’interopérabilité et une fiabilité parfois médiocre des supports de type cartouche.

a. Le consortium LTO

Fort de ce constat, les entreprises Hewlett Packard Entreprise, IBM et Quantum, propriétaire du format SDLT, s’associent vers la fin des années 1990 autour d’un format commun. Ils en définissent les spécifications et lancent alors la première génération de cartouches, avec une capacité native de 100 Go, dans le courant de l’année 2000. La technologie LTO (Linear Tape Open) Ultrium rivalise alors avec celle de chez Sony disposant de son format AIT et de caractéristiques semblables voire parfois supérieures. Au bout de quelques années seulement de distribution, la technologie LTO Ultrium s’impose de facto comme un véritable standard en raflant près de 90% du marché mondial des cartouches...

Editions ENI Livres | Vidéos | e-Formations

Editions ENI Livres | Vidéos | e-Formations