De l’électricité au microprocesseur

Introduction

Dans ce premier chapitre, explorons le parcours fascinant qui a conduit de la découverte de l’électricité à la création des microprocesseurs modernes, composants centraux des ordinateurs qui ont rendu possible l’essor technologique actuel. Depuis les premières expérimentations permettant de comprendre et maîtriser les phénomènes électriques jusqu’à l’invention des transistors et des circuits intégrés, chaque étape a jeté les bases de l’informatique telle que nous la connaissons. Ce chapitre se concentre donc sur les phénomènes électroniques qui ont mené à l’émergence des microprocesseurs modernes ainsi que sur les notions essentielles à la compréhension de leur fonctionnement.

L’aube de l’électricité

L’essor de l’électricité, depuis ses premières découvertes scientifiques jusqu’à son intégration dans la vie quotidienne au tournant du XXe siècle, a marqué la « seconde révolution industrielle », ouvrant la voie à des innovations qui ont transformé les communications, l’industrie, les transports et la vie domestique.

1. Les débuts de l’électricité et ses premières applications

L’histoire de l’électricité commence bien avant que nous puissions l’exploiter à grande échelle. Dès l’Antiquité, les Grecs avaient remarqué que le frottement de certains matériaux, comme l’ambre, contre des tissus, produisait une force capable d’attirer de petits objets. Il s’agissait des premières observations de l’électricité statique. Il fallut cependant attendre plusieurs siècles avant de comprendre pleinement ce phénomène et, surtout, de l’utiliser de manière pratique.

Au XVIIIe siècle, Benjamin Franklin marqua une étape importante en démontrant, grâce à son expérience du cerf-volant sous l’orage, que la foudre était une forme d’électricité. Cette découverte l’amena à inventer le paratonnerre, une première application concrète pour protéger les bâtiments des éclairs. Cependant, à cette époque, l’électricité restait un sujet d’étude scientifique, avec peu d’applications pratiques pour le grand public.

Le véritable tournant survint en 1800, lorsqu’Alessandro...

L’apparition du transistor

L’histoire des composants électroniques commence bien avant l’avènement des transistors et des circuits miniaturisés qui constituent aujourd’hui le cœur de nos appareils. Les premiers composants à la base de l’électronique moderne sont les résistances, les condensateurs et les diodes. Ces éléments fondamentaux ont permis de contrôler le courant électrique, ouvrant la voie aux applications qui allaient suivre.

Décrire le comportement du courant électrique, puis des résistances, des condensateurs n’est pas strictement nécessaire, mais utile pour appréhender en profondeur les concepts présentés dans ce chapitre. Le lecteur ne bénéficiant pas de connaissances de base en électronique est invité à consulter l’annexe - section Arsenal électronique qui introduit quelques notions essentielles utilisées dans ce chapitre.

1. L’invention de la diode à vide : la première vraie avancée en électronique

La première véritable avancée dans le domaine des composants électroniques intervint avec l’invention de la diode à vide par John Ambrose Fleming en 1904. Ce dispositif simple permettait le passage du courant dans une seule direction, et le bloquait dans l’autre, grâce à une cathode chauffée qui émettait des électrons vers une anode. Cette capacité à contrôler la direction du flux d’électrons fut essentielle pour de nombreuses applications, comme le redressement du courant alternatif en courant continu.

La diode à vide fut notamment utilisée dans les premiers récepteurs radio pour détecter les signaux. Cette application, bien que rudimentaire, permit de convertir les signaux radio en courant électrique, ouvrant la voie à la radio moderne et à l’ère des télécommunications. La diode à vide était cependant encombrante et consommait beaucoup d’énergie, ce qui limitait son usage pratique.

2. L’ère de la triode : l’amplification des signaux

En 1906, Lee De Forest améliora la diode à vide en y ajoutant une troisième électrode, créant...

Les circuits numériques

L’évolution de l’électronique, de l’analogique au numérique, a marqué un tournant majeur en remplaçant les signaux continus par des signaux binaires, représentés par 0 et 1. Cette transition a permis de rendre les circuits plus robustes, efficaces et adaptés au traitement et au stockage de grandes quantités de données. À la base de cette évolution se trouvent la logique binaire et les composants fondamentaux comme les portes logiques et les bascules, qui permettent de réaliser des opérations complexes et de manipuler les informations dans les systèmes modernes.

L’émergence de l’électronique numérique a vraiment commencé avec le développement des commutateurs et des circuits logiques. Le travail de Claude Shannon, en 1937, a été fondamental. Il a montré comment utiliser l’algèbre booléenne pour représenter et simplifier des circuits de commutation électrique (interrupteurs), ce qui a jeté les bases théoriques des portes logiques et des circuits numériques.

1. De l’électronique analogique à l’électronique numérique

L’électronique analogique repose sur la manipulation de signaux électriques qui varient de manière continue. Elle est utilisée pour traiter des phénomènes naturels comme le son, la lumière ou la température, qui eux-mêmes sont analogiques par nature. Par exemple, dans les premiers systèmes électroniques tels que les radios et les amplificateurs, les signaux électriques analogiques étaient amplifiés, modulés ou filtrés pour fournir des informations. Les composants fondamentaux de l’électronique analogique sont les résistances, les condensateurs, les transistors, etc.

L’électronique analogique présente plusieurs limites, notamment la sensibilité aux interférences et aux bruits, qui peut dégrader les signaux à mesure qu’ils traversent un circuit. De plus, la manipulation précise de ces signaux devient de plus en plus difficile à mesure que les circuits se complexifient. C’est dans ce contexte que l’électronique numérique...

Les informations binaires

Dans un circuit numérique, les informations sont manipulées exclusivement sous forme binaire. La base binaire y est fondamentale. Les ordinateurs l’utilisent pour effectuer des calculs arithmétiques, comme l’addition et la multiplication, mais également pour manipuler des informations plus structurées ou complexes comme les chaînes de caractères (via l’ASCII), les signaux audio, vidéo, etc. Cette section explore les différents concepts permettant aux ordinateurs de manipuler et stocker efficacement des informations en binaire.

1. La base binaire et le calcul binaire

La base binaire est un système de numérotation qui, tout comme la base décimale que nous utilisons couramment, permet de représenter des nombres et des informations. Cependant, alors que la base décimale utilise dix chiffres (de 0 à 9), la base binaire ne repose que sur deux chiffres : 0 et 1. À chaque chiffre dans un nombre binaire, appelé bit, correspond une puissance de 2, tandis que dans la base décimale, à chaque chiffre correspond une puissance de 10.

Notons que ces questions de bases utilisées n’influencent en rien la capacité à représenter des grandeurs, des nombres ou des informations et à les manipuler. Le choix de la base 10 comme standard mathématique au quotidien est par ailleurs parfaitement arbitraire et ne tient à rien d’autre qu’au fait que l’être humain possède dix doigts.

La figure 2-7 présente une correspondance entre la base décimale et la base binaire pour les quelques premiers nombres entiers naturels.

|

Base décimale |

Base binaire |

|

0 |

0 |

|

1 |

01 |

|

2 |

10 |

|

3 |

11 |

|

4 |

100 |

|

5 |

101 |

|

6 |

110 |

|

7 |

111 |

|

8 |

1000 |

|

9 |

1001 |

|

10 |

1010 |

|

11 |

1011 |

|

12 |

1100 |

|

13 |

1101 |

|

14 |

1110 |

|

15 |

1111 |

|

16 |

10000 |

|

... |

... |

Figure 2-7 - Correspondance entre la base décimale et la base binaire pour les quelques premiers nombres entiers naturels

Le calcul binaire suit des règles identiques au calcul décimal, mais en utilisant seulement les chiffres 0 et 1. Par exemple, l’addition en binaire fonctionne avec des reports, tout comme en décimal : 1 + 1 donne 10 (en binaire), avec un report, tout comme 9 + 1 donne 10 en décimal.

Puisqu’elle se limite aux chiffres 0 et 1, il devient simple de créer des composants...

Les circuits intégrés

Les circuits intégrés (CI ou IC - Integrated Circuit), parfois appelés puces électroniques, sont des dispositifs qui combinent plusieurs composants électroniques sur une seule et même petite plaque de matériau semi-conducteur, généralement du silicium. L’invention du circuit intégré dans les années 1950 a permis de miniaturiser des circuits auparavant constitués de nombreux composants discrets et volumineux.

Les premiers circuits électroniques étaient construits avec des composants individuels, comme des transistors et des résistances, montés d’abord sur des cartes de montage et reliés par des fils électriques, puis soudés sur des circuits imprimés. Ces circuits étaient encombrants, coûteux et peu fiables à grande échelle. En 1958, Jack Kilby chez Texas Instruments et Robert Noyce chez Fairchild Semiconductor ont, indépendamment, développé le concept du circuit intégré. Cette invention a permis de regrouper plusieurs composants sur une seule puce de silicium, ouvrant la voie à une miniaturisation massive des circuits numériques jusqu’à la création des microprocesseurs modernes.

1. L’évolution des circuits intégrés

Les premiers circuits intégrés étaient relativement simples et avaient une fonction très générique. Apparus dans les années 1960, ils n’intégraient que quelques transistors, résistances et condensateurs sur une même puce de silicium pour réaliser des fonctions de base, comme des portes logiques (AND, OR, etc.) ou des compteurs. Ces premiers circuits étaient utilisés pour remplacer les composants discrets, permettant de miniaturiser les systèmes tout en les rendant plus fiables.

Puis...

Les microprocesseurs

L’avancée technologique majeure que furent les circuits intégrés a rapidement conduit au développement des premiers microprocesseurs dans les années 1970. Un microprocesseur est essentiellement un circuit intégré qui regroupe toutes les fonctions de calcul et de traitement d’un ordinateur sur une seule puce. En combinant des milliers de transistors au sein de portes logiques, registres et autres composants élémentaires nécessaires dans un espace minuscule, les microprocesseurs ont permis de créer des ordinateurs plus compacts et puissants, ouvrant la voie à l’émergence des technologies modernes.

1. Les premiers microprocesseurs

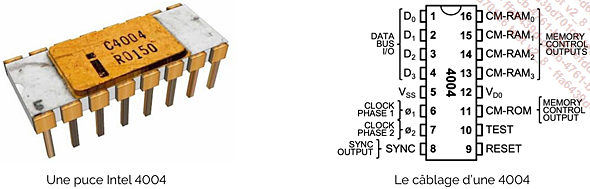

L’Intel 4004, lancé en 1971, est considéré comme le premier microprocesseur commercial. Il s’agissait d’une puce 4 bits, capable d’exécuter environ 92 000 instructions par seconde. Conçu à l’origine pour des calculatrices, il a ouvert la voie à l’utilisation de processeurs intégrés dans des systèmes informatiques.

Figure 2-13 - Le microprocesseur Intel 4004

Son successeur, l’Intel 8008, est lancé en 1972. Il s’agit d’un processeur 8 bits capable de traiter des données plus complexes. En 1974, l’Intel 8080 améliore encore les performances et devient l’un des premiers processeurs utilisés...

L’architecture d’un microprocesseur

L’architecture d’un microprocesseur moderne est divisée en plusieurs macro-unités qui collaborent pour exécuter les instructions et gérer les flux de données de manière efficace. Le schéma de la figure 2-16 illustre les principaux composants d’un microprocesseur, ou du moins les plus communs, chacun ayant un rôle spécifique dans l’exécution des instructions.

Figure 2-16 - L’architecture simplifiée d’un microprocesseur

Voyons le but et le fonctionnement de chacun de ces composants.

1. Unité de contrôle (CU)

L’unité de Contrôle (Control Unit - CU) supervise et coordonne l’ensemble des opérations dans le processeur. Elle reçoit des instructions de l’unité de contrôle des instructions (ICU), puis orchestre leur exécution en dirigeant le flux de données entre les différentes sous-unités du processeur.

-

Supervision : elle gère l’ordre global des opérations et s’assure que chaque unité du processeur fonctionne en synchronisation.

-

Synchronisation : elle assure que les différents composants travaillent de manière ordonnée et évite les conflits de timing.

-

Contrôle : il supervise le comportement général du CPU en fonction des signaux d’état et des résultats des opérations.

2. Unité d’exécution (EU)

L’unité d’exécution (Execution Unit - EU) est la partie du processeur où les instructions sont réellement exécutées, principalement en calculant des résultats ou en réalisant des opérations logiques. Elle comprend plusieurs sous-unités.

Les registres

Les registres sont des petites zones de stockage à très haute vitesse, directement intégrées dans le processeur. Leur rôle principal est de stocker temporairement des données ou des instructions lors du traitement par l’ALU, la FPU, ou d’autres unités de calcul. Les registres sont directement accessibles par l’unité d’exécution, et sont utilisés pour stocker des opérandes intermédiaires, les résultats des calculs, ou des adresses pour les accès...

Les architectures CISC et RISC

Les architectures CISC (Complex Instruction Set Computer) et RISC (Reduced Instruction Set Computer) sont, d’une certaine façon, deux grandes écoles de pensée dans la conception des processeurs, chacune née d’une approche différente face aux défis posés par la technologie de l’époque.

Dans les premières décennies de l’informatique, les processeurs étaient principalement basés sur l’architecture CISC. L’idée sous-jacente à cette conception était fondamentalement de simplifier la vie des programmeurs. Les ingénieurs des années 1960 et 1970 pensaient qu’il serait plus efficace de créer un ensemble d’instructions élaborées, capables d’accomplir des tâches très complexes en un minimum d’opérations de haut niveau. Chaque instruction peut demander plusieurs cycles d’horloge pour être exécutée, mais cela permet de traiter des opérations de haut niveau avec peu de lignes de code. Par exemple, un processeur CISC peut réaliser des opérations complexes de gestion de chaînes de caractères ou de multiplication tout en opérant sur la mémoire, directement, au moyen d’une seule instruction.

Cependant, dans les années 1980, des chercheurs, notamment ceux de l’Université...

Le cœur de l’informatique moderne

Depuis les premières expérimentations permettant de comprendre les phénomènes électriques jusqu’à l’invention des transistors et des circuits intégrés, chaque étape a mené au fil des décennies à l’arrivée des microprocesseurs actuels. Le microprocesseur est au cœur de l’informatique moderne, jouant le rôle de « cerveau » de presque tous les dispositifs électroniques que nous utilisons au quotidien. Que ce soit dans un ordinateur, un smartphone, une voiture connectée ou même dans les objets de notre maison, il orchestre les opérations, exécute les calculs, et coordonne les actions en temps réel.

Dans les prochains chapitres, nous comprendrons le rôle du microprocesseur au sein de l’ordinateur et ses interactions avec le système d’exploitation pour matérialiser les fonctions informatiques que nous utilisons. Notamment dans le chapitre Fonctionnement d’un ordinateur, nous verrons que le microprocesseur n’est pas seul au sein d’un ordinateur, beaucoup d’autres composants lui sont nécessaires pour fonctionner.

Editions ENI Livres | Vidéos | e-Formations

Editions ENI Livres | Vidéos | e-Formations