Des usages militaires à l’ère digitale

Introduction

Ce chapitre explore l’évolution fascinante des ordinateurs, depuis leurs débuts dédiés aux applications militaires et scientifiques jusqu’à leur transformation en un outil omniprésent, accessible à tous et au cœur de notre quotidien. L’informatique, initialement réservée aux besoins de calcul intensif pour des projets de recherche ou des applications militaires, s’est progressivement démocratisée. Elle est passée par l’ère des mainframes, des micro-ordinateurs et des ordinateurs personnels, jusqu’à devenir une technologie essentielle aussi bien pour les individus que pour les entreprises.

Des premiers ordinateurs aux machines de Turing

L’histoire des premières machines que l’on peut appeler « ordinateurs » est une fascinante progression de découvertes et d’innovations, chaque étape construisant sur la précédente pour nous amener progressivement vers l’informatique moderne. Pour les découvrir, partons de l’origine, des premières machines électromécaniques, jusqu’à l’apparition de l’ordinateur à transistor.

1. Les premiers calculateurs électromécaniques

Tout commence dans les années 1930 et 1940, à une époque où les scientifiques et les ingénieurs cherchent à automatiser les calculs. Le premier jalon de cette aventure est posé par Konrad Zuse, un ingénieur allemand, qui crée en 1941 le Z3 : la toute première machine que l’on peut qualifier d’ordinateur électromécanique programmable. Le Z3 utilisait des relais électromécaniques pour effectuer des opérations arithmétiques. Bien que rudimentaire et relativement lent, il marquait un grand pas en avant : pour la première fois, une machine pouvait exécuter des instructions automatiquement, sans intervention humaine directe à chaque étape.

Figure 4-1 - Une reconstruction de 2010 de l’ordinateur Z3 par Horst Zuse Auteur : Dksen sur German Wikipedia (image dans le domaine public)

Presque au même moment, aux États-Unis, une autre machine révolutionnaire voit le jour : le Harvard Mark I, construit en collaboration entre Howard Aiken et IBM en 1944. Cette machine électromécanique gigantesque, de plus de 15 mètres de long, était capable d’effectuer des calculs complexes, principalement pour des applications militaires pendant la Seconde Guerre mondiale. Bien qu’il fût encore basé sur des relais, le Mark I pouvait traiter des séries d’instructions de manière automatique et était capable de travailler pendant des heures sans intervention.

2. Alan Turing et ses bombes

Pendant la guerre, la cryptanalyse joua un rôle crucial, et l’une des figures clés de cette bataille était Alan Turing, mathématicien britannique dont les travaux ont été...

Les mainframes

L’histoire des mainframes est une partie fascinante de l’évolution des ordinateurs, marquée par l’industrialisation de l’informatique pour les grandes entreprises et les gouvernements. Les mainframes, aussi appelés ordinateurs centraux, sont des systèmes de calcul puissants conçus pour gérer de grands volumes de données et des applications critiques. Leur histoire s’étend sur plus de sept décennies, commençant dans les années 1950 et se poursuit jusqu’à aujourd’hui, où ils continuent à jouer un rôle clé dans certains secteurs.

Un mainframe se distingue d’un ordinateur personnel moderne par le concept de terminaux connectés à un ordinateur central. Dans un environnement mainframe traditionnel, les utilisateurs n’interagissent pas directement avec le mainframe, ni au moyen d’ordinateurs personnels connectés à un réseau. Ils utilisent des terminaux connectés au mainframe par liaison filaire et protocole de communication propriétaire. Ces terminaux ne possèdent pas de capacités de traitement indépendantes ; ils ne sont que des interfaces et servent uniquement à envoyer des entrées (données) au mainframe central et à recevoir les résultats du traitement pour les afficher. Le mainframe effectue toutes les opérations lourdes, tandis que les terminaux agissent comme des interfaces d’interaction avec le système central.

1. Les débuts des mainframes : les années 1950

L’histoire des mainframes commence dans les années 1950, une époque où les ordinateurs étaient de grandes machines complexes, principalement utilisées par les gouvernements et les grandes entreprises pour des tâches de calcul intensif. Le développement des mainframes est étroitement lié aux progrès dans l’électronique, en particulier l’invention des tubes à vide, puis des transistors.

L’UNIVAC I (Universal Automatic Computer) vu précédemment est Le premier ordinateur généralement reconnu comme un mainframe.

Parallèlement, IBM (International Business Machines) a fait ses premiers pas dans l’industrie des ordinateurs avec...

Et à part les mainframes ?

IBM et ses mainframes ont certes joué un rôle essentiel dans l’évolution de l’informatique. Mais d’autres entreprises comme Cray, Silicon Graphics (SGI) et Sun Microsystems ont également eu un impact très important, notamment dans le domaine des superordinateurs, des graphiques avancés et des serveurs. Chacune de ces entreprises a développé des innovations spécifiques qui ont élargi les possibilités en matière de calcul haute performance, de visualisation graphique et de serveurs applicatifs et inspiré les technologies des systèmes modernes. Voici un résumé de l’histoire de ces entreprises et de leurs machines emblématiques.

1. Cray Inc. - la révolution des superordinateurs

Fondée en 1972 par Seymour Cray, Cray Research est devenue célèbre dans le domaine du calcul haute performance (HPC - High Performance Computing) avec ses superordinateurs. Dès son origine, Cray s’est fixé pour objectif de concevoir des machines parmi les plus puissantes au monde mais de taille raisonnable, destinées à des tâches complexes et intensives en calcul, comme les simulations scientifiques, la météorologie et la recherche nucléaire.

Le premier superordinateur de Cray, le Cray-1, sorti en 1976, était extrêmement rapide pour l’époque, capable d’effectuer des milliards de calculs par seconde. Le Cray-1 utilisait une architecture vectorielle, permettant de traiter de grandes quantités de données en parallèle, et il est devenu une référence du calcul scientifique de pointe. Cette machine a été utilisée par des laboratoires de recherche, des agences gouvernementales et des entreprises nécessitant des capacités de simulation avancée.

Les générations suivantes, comme le Cray-2 (1985) et le Cray Y-MP (1988), ont encore amélioré la puissance de calcul, introduisant des innovations comme le refroidissement...

L’ère de la micro-informatique

Nous avons vu jusqu’ici dans ce chapitre l’histoire des principaux gros systèmes industriels, des mainframes aux supercalculateurs, qui ont dominé les applications en entreprise pendant plusieurs décennies. Mais parallèlement à ces systèmes, des micro-ordinateurs, initialement conçus pour le milieu académique puis destinés à un usage personnel, ont fait leur apparition dès la fin des années 60. Ces systèmes, d’abord confidentiels, ont augmenté leur part de marché régulièrement et systématiquement, jusqu’à devenir l’écrasante majorité des systèmes supportant les applications industrielles dans les années 1990. Aujourd’hui, même les systèmes les plus complexes, comme les infrastructures informatiques des géants du Web, fonctionnent exclusivement sur du matériel informatique standardisé ou personnel (commodity hardware). Nous reviendrons longuement sur ce sujet dans le chapitre L’architecture des SI : du mainframe au Big Data. Mais parlons d’abord de l’avènement de la micro-informatique.

L’histoire de la micro-informatique est marquée par une succession d’innovations technologiques majeures, portées par des entreprises pionnières qui ont contribué à démocratiser l’informatique et à rendre les ordinateurs personnels (PC - Personal Computer) accessibles à tous. Il y eut un très grand nombre de ces différents ordinateurs et entreprises, certainement trop pour les mentionner tous. Nous nous bornerons donc à évoquer les plus connus.

Chacune de ces entreprises a contribué à façonner l’histoire de la micro-informatique en apportant des innovations qui ont permis à l’informatique de devenir un outil universel et indispensable. Des mini-ordinateurs de DEC aux PC d’IBM, en passant par les interfaces graphiques d’Apple et les logiciels de Microsoft, chacun de ces acteurs et étapes ont contribué à amener l’informatique à son omniprésence actuelle. Leur impact n’a pas seulement été technique, mais aussi sociétal, redéfinissant la manière dont...

Des lecteurs de cartes perforées au cloud

L’histoire du stockage de données, des cartes perforées au cloud, est un reflet de l’évolution technologique rapide des cinquante dernières années. Chaque nouvelle étape a apporté des capacités accrues, une accessibilité améliorée et une gestion des données plus efficace. Aujourd’hui, le stockage cloud a marqué une nouvelle évolution, en offrant une solution dématérialisée et évolutive qui libère les utilisateurs des contraintes physiques, tout en rendant les données accessibles à tout moment et surtout de n’importe où.

1. Les cartes perforées : les débuts du stockage mécanique

Le besoin de stocker des données exploitables par des systèmes électromécaniques est apparu bien avant les premiers ordinateurs programmables. La première technologie disponible consistait à utiliser des cartes perforées, une approche dérivée des métiers à tisser de Joseph Marie Jacquard.

Inventées par Herman Hollerith à la fin du XIXe siècle, les cartes perforées étaient utilisées pour encoder des informations sous forme de trous, chaque trou représentant un bit d’information. Ces cartes étaient ensuite lues par des machines électromécaniques, comme celles utilisées pour le recensement américain de 1890. Les cartes perforées ont ensuite été largement utilisées avec les premiers ordinateurs, jusque dans les années 1970 pour entrer des programmes ou des données dans ces derniers, mais elles avaient de nombreuses limites, surtout en termes de capacité et maniabilité des données.

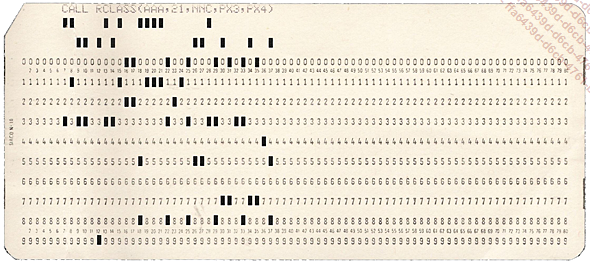

Figure 4-15 -Carte Perforée de 1967 ©Mutatis mutandis / Wikimedia - https://creativecommons.org/licenses/by/2.5/deed.en

Les cartes perforées fonctionnaient selon un principe simple : elles stockaient des données sous forme de trous perforés dans une matrice de positions prédéfinies sur la carte. Chaque trou représentait un bit d’information (généralement un 1, l’absence de trou...

Les acteurs majeurs du logiciel

Outre Microsoft, plusieurs autres entreprises majeures ont façonné le monde du logiciel et continuent d’influencer profondément l’industrie aujourd’hui. Des entreprises comme Oracle, Adobe, SAP et VMware ont chacune joué un rôle important dans la transformation des environnements professionnels, des solutions d’entreprise, des outils de création ou encore de l’infrastructure informatique.

1. Oracle : le géant des bases de données

Fondée en 1977 par Larry Ellison, Bob Miner, et Ed Oates, Oracle a initialement développé un système de gestion de bases de données relationnelles (SGBDR ou RDBMS - Relational DataBase Management System).

Le concept de bases de données relationnelles permet aux entreprises de stocker, organiser et interroger de grands volumes de données de manière flexible, efficace et cohérente. Oracle a rapidement dominé ce marché grâce à sa technologie performante et fiable, marché qu’il domine toujours aujourd’hui, même si l’hégémonie des SGBDR se réduit. Nous y reviendrons également au chapitre L’architecture des SI : du mainframe au Big Data.

Dans les années 1990 et 2000, Oracle a diversifié son offre en acquérant des entreprises comme PeopleSoft et Sun Microsystems (avec...

L’informatisation massive des entreprises

L’histoire de l’informatisation des entreprises est une histoire d’adaptation et d’évolution technologique qui commence avec l’introduction des mainframes dans les années 1950, se poursuit avec la généralisation des ordinateurs personnels et aboutit aujourd’hui à des solutions dématérialisées comme le cloud et les technologies Java. Ce processus a vu les entreprises, grandes d’abord, puis moyennes et petites, transformer la gestion des informations, passer du papier et des classeurs d’archives aux bases de données numériques, et adopter des systèmes sophistiqués pour automatiser et rationaliser leurs opérations.

1. Les débuts avec les mainframes - années 1950 à 1970

L’informatisation des entreprises commence avec l’introduction des mainframes dans les grandes entreprises dans les années 1950 et 1960. Ces systèmes centraux étaient utilisés exclusivement par les très grandes entreprises pour automatiser des tâches complexes et lourdes comme la comptabilité, la gestion des stocks et la facturation. Des entreprises dans des secteurs tels que la banque, l’assurance et l’industrie lourde ont été les premières à adopter ces technologies permettant de gérer de grandes quantités de données à travers des terminaux connectés à un ordinateur central.

Les mainframes étaient très coûteux et exigeaient des salles spéciales, des équipes techniques dédiées et un savoir-faire informatique poussé. Seules les grandes entreprises avaient les moyens d’investir dans de telles infrastructures. Les moyennes et petites entreprises n’avaient à cette époque ni l’accès ni les ressources nécessaires pour utiliser de tels systèmes, et continuaient donc à gérer leurs informations manuellement, sur du papier.

2. L’apparition des mini-ordinateurs - années 1970 à 1980

Dans les années 1970, l’introduction des mini-ordinateurs, comme le PDP de DEC, a été une révolution pour les entreprises de taille moyenne. Ces machines étaient plus petites et moins coûteuses...

L’évolution des interfaces homme-machine

L’évolution des interfaces homme-machine (IHM ou UI - User Interface), c’est-à-dire les moyens par lesquels nous interagissons avec les machines, témoigne de la progression rapide et continue des technologies informatiques. Depuis les débuts, où les dispositifs interactifs étaient mécaniques et peu intuitifs, jusqu’aux approches les plus modernes comme la « réalité augmentée » ou la « réalité virtuelle », l’évolution des IHM a toujours cherché à permettre à l’homme et la machine de s’interfacer de façon plus dynamique et profonde, rendant les systèmes informatiques plus accessibles, immersifs et efficaces.

1. Les débuts : machines à écrire et interfaces textuelles

L’histoire des interfaces homme-machine commence avec des dispositifs mécaniques imitant les machines à écrire. Elles étaient la première forme d’interface entre l’humain et la machine, transformant des actions physiques en caractères imprimés, et ont inspiré l’introduction du clavier, qui reste un élément fondamental des interfaces actuelles.

Figure 4-20 - Un téléimprimeur Auteur : Wolfgang Stief from Tittmoning, Germany / Wikimedia (image dans le domaine public)

Ces téléimprimeurs (également appelés terminaux TéléTYpe - TTY) permettaient de saisir les commandes ligne par ligne, et chaque action produisait une sortie imprimée sur des feuilles de papier enchaînées qui se déroulaient derrière la machine. Le TTY a ensuite évolué vers l’interface basée sur le terminal que l’on connaît aujourd’hui, utilisant des écrans pour afficher du texte.

2. L’arrivée de l’écran et du clavier : interfaces graphiques de base

L’invention de l’écran a permis une révolution dans les IHM en affichant les informations en temps réel. Même...

La virtualisation et la conteneurisation

La virtualisation et la conteneurisation sont deux technologies clés qui permettent d’exécuter des logiciels dans des environnements isolés, tout en s’abstrayant du matériel sous-jacent. Elles offrent un moyen de découpler les applications de l’infrastructure physique, facilitant ainsi la portabilité, la gestion des ressources et la flexibilité des déploiements. Elles jouent un rôle central dans les architectures informatiques modernes basées sur les infrastructures de type cloud computing, en facilitant le déploiement, la gestion et la scalabilité des applications. Bien qu’elles visent des objectifs similaires, ces technologies fonctionnent de manières différentes et présentent chacune des avantages et des inconvénients.

1. La virtualisation

La virtualisation permet de créer plusieurs machines virtuelles (ou VM pour Virtual Machine) indépendantes sur une seule machine physique (réelle). À l’aide d’un logiciel appelé « hyperviseur », chaque machine virtuelle fonctionne comme une machine indépendante, avec son propre système d’exploitation, ses applications et ses ressources de traitement, de stockage et de mémoire. C’est réellement comme si plusieurs machines fonctionnaient en parallèle au sein d’une même machine physique.

La généralisation de ce modèle fut véritablement révolutionnaire puisqu’il devint possible à toute entreprise de créer des « machines » autonomes au sein d’une machine physique partagée. Par exemple, un serveur physique unique peut héberger plusieurs environnements Windows, Linux et macOS en même temps, chacun étant isolé des autres et fonctionnant comme s’il s’agissait d’un ordinateur distinct. Cette approche optimise l’utilisation des ressources physiques, car chaque machine virtuelle peut être configurée en fonction des besoins de l’application qui y est installée, sans interférence avec les autres systèmes qui coexistent sur le même matériel.

Cette isolation des machines virtuelles a pour avantage de fournir une séparation stricte entre...

L’omniprésence de l’informatique

Aujourd’hui, nous vivons dans une ère d’omniprésence de l’informatique, où les technologies numériques sont intégrées dans presque tous les aspects de notre vie quotidienne. L’informatique n’est plus limitée à des machines visibles comme les ordinateurs de bureau ou les serveurs, mais est intégrée dans une multitude de dispositifs, des smartphones aux objets connectés (IoT - Internet of Things), en passant par les voitures autonomes, les appareils domestiques intelligents et même les infrastructures urbaines.

Cette informatique invisible et omniprésente requiert une connectivité permanente, une gestion en temps réel des données et des interactions fluides entre les objets et les systèmes. L’information est produite en tout lieu et à tout moment, et accessible partout et en permanence, transformant radicalement les modes de communication, de travail et de consommation.

C’est également l’ère de la puissance. La croissance de la puissance informatique disponible globalement est exponentielle. Avec les avancées en intelligence artificielle, les technologies Big Data, la robotique et le cloud computing, la capacité des systèmes informatiques à traiter des quantités massives de données pour automatiser...

Editions ENI Livres | Vidéos | e-Formations

Editions ENI Livres | Vidéos | e-Formations