L'intelligence artificielle

Introduction

L’intelligence artificielle (ou IA), deux mots que l’on entend désormais tous les jours, à la radio, à la télévision, sur Internet… résumant un ensemble de techniques informatiques cherchant à simuler l’intelligence humaine.

Mais qu’est-ce que l’intelligence ?

Dans notre monde, celle-ci peut prendre plusieurs formes. Elle peut représenter la capacité d’adaptation d’un être vivant, s’adaptant à des situations nouvelles, résolvant des problèmes de plus en plus complexes, apprenant de l’expérience engrangée et pensant de manière abstraite.

Elle peut aussi être émotionnelle, reconnaissant, comprenant et gérant ses propres émotions et celles des autres.

Mais alors, l’intelligence est-elle uniquement humaine ? Ou peut-elle exister chez les animaux, voire les machines ? Est-elle innée, acquise, les deux à la fois ?

Comment la mesurer objectivement ? Est-elle liée à la conscience d’exister ?

Tout comme nous, l’IA ne peut vivre sans des atomes présents dans la nature. Son eau ? L’électricité. Ses veines ? Des circuits imprimés. Son cerveau ? Une succession de réseaux neuronaux artificiels, d’octets, d’algorithmes.

Elle a des capacités similaires aux nôtres, telles que l’apprentissage (machine learning), le raisonnement, la perception (vision par ordinateur, reconnaissance vocale), la compréhension du langage naturel ou encore la prise de décision autonome.

Nous avons créé une entité de toutes pièces, à notre image, mais qui peut désormais évoluer de manière autonome. Si une IA peut apprendre et décider, en quoi sommes-nous différents ? Cela remet en question notre propre conception du libre arbitre.

Mais une différence majeure demeure : contrairement à la plupart des êtres humains qui l’ont créée, l’IA ne ressent pas d’émotions, elle ne peut pas faire preuve de subjectivité mais peut en revanche simuler parfaitement… l’intelligence humaine.

En d’autres termes, et c’est le sens du test de Turing, « suffit-il qu’une machine imite l’humain pour être considérée comme intelligente ? »

1. Test de Turing

Ce test est une expérience de pensée proposée en 1950 par le mathématicien et logicien britannique Alan Turing, dans son article intitulé...

L’IA a 75 ans

L’intelligence artificielle, bien que souvent perçue comme une technologie du XXIe siècle, plonge ses racines dans des réflexions philosophiques et mathématiques bien plus anciennes. Dès l’Antiquité, les mythes grecs évoquaient des automates dotés de volonté propre, comme Talos, le géant de bronze. Mais c’est au XXe siècle que l’IA prend forme en tant que discipline scientifique.

1940-1950 : les prémices théoriques

L’un des jalons fondateurs est posé par Alan Turing, mathématicien britannique, qui propose en 1950 le célèbre test de Turing dont j’ai parlé plus tôt pour évaluer la capacité d’une machine à imiter l’intelligence humaine. En parallèle, les premiers ordinateurs électroniques voient le jour, ouvrant la voie à la simulation de processus cognitifs.

1956 : naissance officielle de l’IA

Le terme « Artificial Intelligence » est formellement introduit lors de la conférence de Dartmouth en 1956, organisée par John McCarthy, Marvin Minsky, Claude Shannon et Nathaniel Rochester. L’objectif ? Créer des machines capables de raisonner, apprendre et résoudre des problèmes. Cette période marque le début de l’enthousiasme autour de l’IA symbolique, fondée sur des règles logiques explicites.

1970 - 1990 : désillusions et hivers de l’IA

Malgré des avancées prometteuses, les limites technologiques (puissance de calcul, données limitées) freinent les ambitions. Les financements diminuent, et l’IA entre dans ce que l’on appelle les « AI winters » (les hivers de l’IA). Les systèmes d’IA, bien que performants dans des domaines restreints, peinent à s’adapter à des contextes d’entreprise.

1997 : Deep Blue bat Kasparov

Un tournant symbolique survient lorsque Deep Blue, superordinateur d’IBM, bat le champion du monde d’échecs Garry Kasparov. L’IA démontre alors sa capacité à surpasser l’humain dans des tâches complexes, mais reste encore très spécialisée.

Image d’illustration...

Concepts clés

Avant de rentrer dans le vif du sujet de ce que propose Microsoft dans le domaine de l’IA, parlons le même langage. En effet, ne connaissant pas, cher lecteur ou lectrice, vos connaissances et compétences sur ce vaste écosystème, voici un résumé de la signification des principaux termes utilisés dans cet ouvrage :

1. Prompt (entrée)

Un prompt est une requête ou une consigne que l’on donne à un modèle. Il peut contenir :

-

Une instruction : ce que l’on attend du modèle.

-

Un contexte : des informations supplémentaires pour guider la réponse.

-

Des données d’entrée : texte, tableau, image, etc.

-

Un indicateur de sortie : format ou style attendu (ex. : résumé, tableau, code).

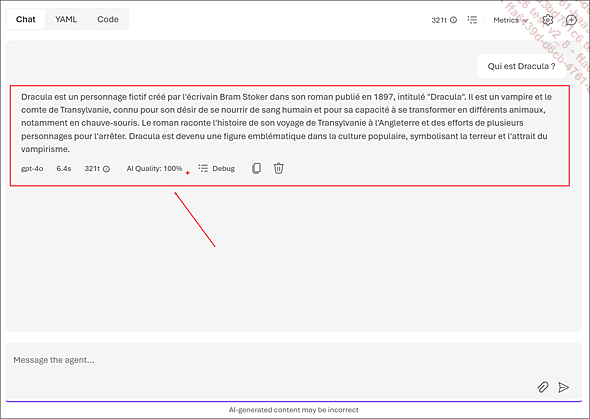

Dans l’image ci-dessous, le prompt correspond à « Qui est Dracula ? »

2. Completion (sortie)

La completion (ou complétion en français) est le mécanisme central des modèles de langage comme GPT. Elle désigne le processus par lequel le modèle prédit et génère la suite d’un texte à partir d’un prompt donné.

En fournissant un prompt, le modèle va l’analyser en le découpant en tokens puis chercher à comprendre le contexte. Il va ainsi prédire le token suivant en s’appuyant sur des milliards de paramètres appris pendant l’entraînement. L’opération sera répétée token après token, jusqu’à atteindre une limite ou un critère d’arrêt (longueur, ponctuation, etc.).

Dans l’image ci-dessous, la complétion correspond à la réponse (sortie) du modèle :

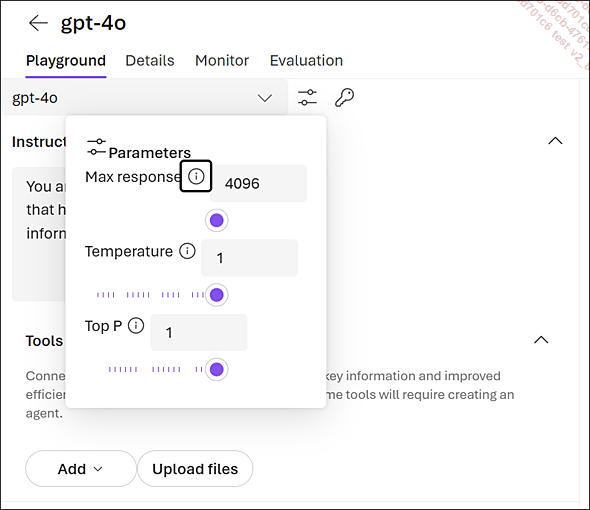

Notez que plusieurs paramètres influencent la completion, comme la Temperature (contrôle la créativité), le Top-p (limite les choix aux tokens les plus probables), le Max tokens (limite la longueur d’une réponse) ou encore le stop sequences (indique au modèle quand s’arrêter). Ces paramètres seront détaillés dans le chapitre Microsoft Foundry - la fabrique d’IA de l’entreprise.

3. Token (jeton)

Les modèles de langage ne raisonnent pas sur des phrases entières...

L’intelligence artificielle déclenchera-t-elle le déclin de l’humanité ?

Plus nous déléguons notre réflexion à la machine, plus nous risquons d’atrophier notre cerveau, de le sous-utiliser, et de perdre des compétences acquises au fil des siècles. En effet, à force d’interroger une IA pour le moindre problème « au lieu d’utiliser notre intelligence », notre cerveau pourrait perdre de ses facultés mentales, jusqu’à devenir un simple auxiliaire dépourvu d’autonomie.

Pourquoi ? Car le cerveau est un muscle : non sollicité, il s’affaiblit.

Faut-il alors ressentir la crainte d’une humanité hypnotisée par le confort intellectuel que procure l’IA, au point de perdre le goût de l’effort mental ?

L’exemple de l’apparition de la machine à calculer donne du poids à cette thèse : il est tellement facile désormais d’utiliser une calculatrice afin d’éviter d’effectuer le moindre calcul mental. Quid de l’utilisation systématique des outils de correction grammaticale dans toutes nos correspondances électroniques ?

Que dire aussi de l’avènement du GPS (Global Positioning System) et des systèmes tels que l’App Waze qui l’utilise ? Il y a plus de vingt ans, nous utilisions des cartes de la France pour aller d’un point A à un point B, travaillant la topographie et notre sens de l’orientation. Maintenant nous faisons une confiance aveugle à un algorithme pour trouver le chemin le plus rapide vers notre destination, allant jusqu’à ignorer les panneaux pour se concentrer sur notre smartphone.

Ainsi, l’IA générative pourrait nous ôter jusqu’à la capacité d’écrire ou de lire sans assistance : si nous nous habituons à ce qu’elle rédige à notre place, composer le moindre paragraphe sans son aide deviendra une épreuve bien plus difficile qu’avant.

Un autre risque concerne les données d’entraînement : si celles-ci sont corrompues, mettant en avant les « fake news » et remettant en cause des vérités scientifiques...

Editions ENI Livres | Vidéos | e-Formations

Editions ENI Livres | Vidéos | e-Formations