Microsoft Foundry - la fabrique d'IA de l'entreprise

Introduction

Logo de Microsoft Foundry

Microsoft Foundry est une plateforme unifiée de Microsoft Azure dédiée au développement d’applications et d’agents en intelligence artificielle générative à l’échelle de l’entreprise.

Elle combine des modèles d’IA avancés, des outils de développement intégrés et une infrastructure cloud industrielle, le tout avec des mécanismes de sécurité et de gouvernance prêts à l’emploi.

Foundry unifie ainsi au sein d’une même offre la gestion des modèles, des agents conversationnels et des services qui les entourent, ce qui permet aux développeurs de se concentrer sur la création d’expériences IA sans se soucier du déploiement sous-jacent.

Cette plateforme s’inscrit dans un mouvement où les idées peuvent passer du prototype en quelques heures à une solution en production en quelques jours, grâce à un écosystème cohérent reliant code, collaboration et cloud - écosystème dont Microsoft dispose en réunissant Visual Studio Code, GitHub et Azure.

La promesse de Foundry : permettre de passer d’une idée à une solution IA opérationnelle (dans le cloud ou localement) en quelques jours, là où il fallait des mois auparavant...

Accès, disponibilité et modèle de licence

Le nouveau portail Microsoft Foundry a été annoncé fin 2025, remplaçant l’ancien portail (Azure AI Foundry) et marquant une étape clé avec la disponibilité générale de son service d’agents et de nombreuses nouveautés.

À la date d’écriture de cet ouvrage (janvier 2026), les deux portails (Microsoft Foundry et Azure AI Foundry) continuent de coexister depuis la même URL. Toutes les fonctionnalités de l’ancien portail n’ont pas été migrées vers le nouveau portail. C’est pourquoi certains exercices de ce chapitre seront effectués depuis l’ancien portail, mais une grande majorité sera à effectuer depuis le nouveau.

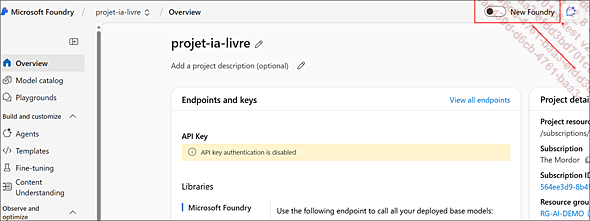

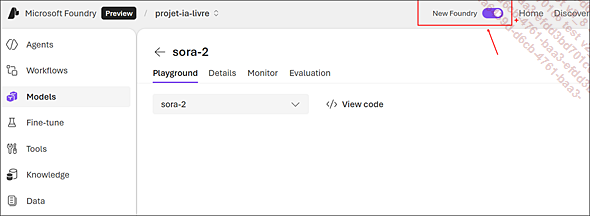

Pour passer de l’ancien portail vers le nouveau ayant la même URL (https://ai.azure.com/), et inversement, il suffit de cocher une case (ou de la décocher en fonction de l’objectif).

Vue de l’ancien portail pour accéder au nouveau portail :

Vue du nouveau portail pour accéder à l’ancien portail :

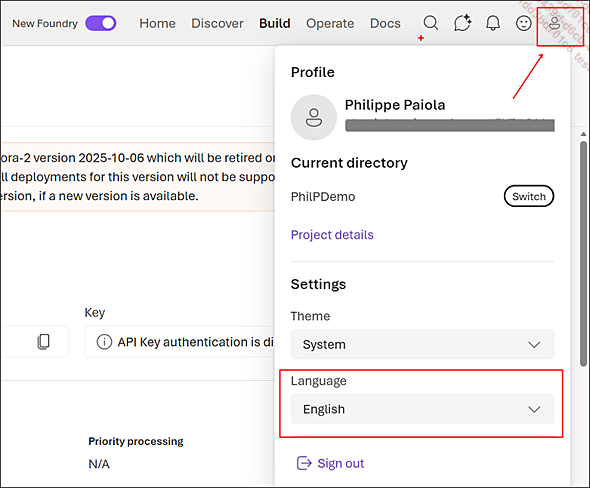

En raison de la qualité de la traduction française jugée insuffisante, il a été décidé d’utiliser uniquement l’interface des portails en anglais.

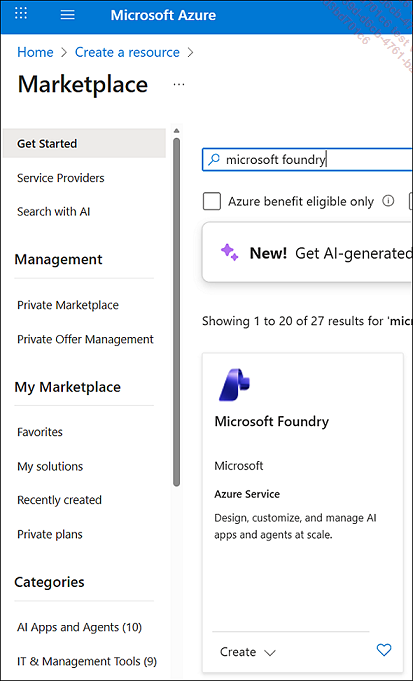

La plateforme Microsoft Foundry est désormais accessible sur le portail Azure en tant que ressource, que les administrateurs peuvent créer dans un abonnement comme n’importe quel service Azure classique.

Le portail Microsoft Foundry est accessible depuis l’URL : https://ai.azure.com/

Chaque ressource Foundry offre un environnement de projet isolé pour une équipe.

Durant la phase de préversion de l’ancien portail (en 2024), un mode hub existait, mais la version actuelle s’appuie sur des projets Foundry natifs, plus simples à configurer et bénéficiant de toutes les capacités récentes (API unifiée, Agent, etc.).

1. Token vs PTU

Du point de vue licence et coût, Microsoft Foundry adopte par défaut un modèle avec paiement à l’usage (pay-as-you-go), sans frais d’abonnement fixes pour l’utilisation de la plateforme.

En pratique, les coûts proviennent de l’utilisation des modèles d’IA...

Fonctionnalités phares de la plateforme Microsoft Foundry

Foundry est riche en composantes et s’appuie principalement sur un projet pour organiser votre travail afin d’explorer de nouvelles idées à mesure que vous prototypez un cas d’usage particulier.

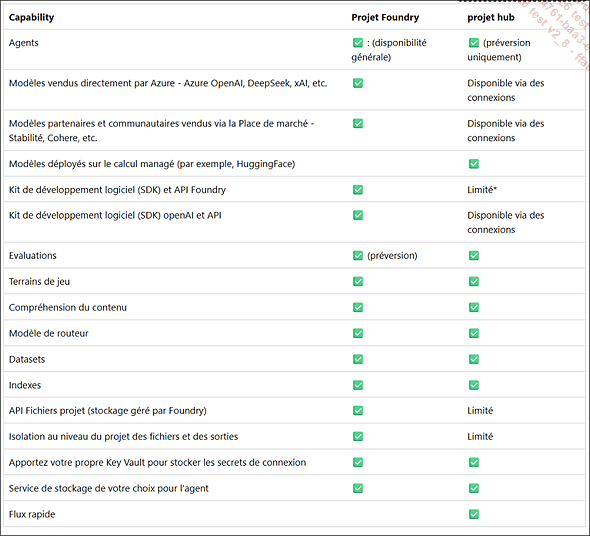

Microsoft Foundry prend en charge deux types de projets : un projet Foundry et un projet hub.

-

Un projet Foundry repose sur une ressource Microsoft Foundry. Ce type de projet permet une configuration simple, un accès aux agents, des modèles de pointe (OpenAI, Mistral, Meta, etc.), de bénéficier des évaluations, une optimisation...

-

Un projet basé sur un hub est lui aussi hébergé dans Microsoft Foundry mais il nécessite des ressources supplémentaires (Azure Key Vault, compte de stockage, etc.). Si votre entreprise dispose d’une équipe administrative qui a déjà créé un hub pour vous, vous pouvez créer un projet à partir de ce hub.

Dans la plupart des cas, vous utiliserez un projet Foundry.

Ce tableau récapitule les fonctionnalités disponibles dans les deux types de projet :

Source : https://learn.microsoft.com/fr-fr/azure/ai-foundry/what-is-azure-ai-foundry#project-types

Nous allons créer un projet Foundry ensemble afin de pouvoir utiliser toutes les fonctionnalités proposées par le portail.

Un abonnement Azure est requis, vous pouvez en obtenir un gratuitement depuis le lien https://azure.microsoft.com/fr-fr/pricing/purchase-options/azure-account?icid=azurefreeaccount. Vous devez aussi être propriétaire de l’abonnement pour avoir le contrôle d’accès approprié nécessaire pour créer la ressource Microsoft Foundry qui est le parent du projet.

Depuis le portail Microsoft Foundry (https://ai.azure.com/), authentifiez-vous avec un e-mail professionnel (exemple : user@contoso.com) ou personnel (exemple : user@hotmail.com).

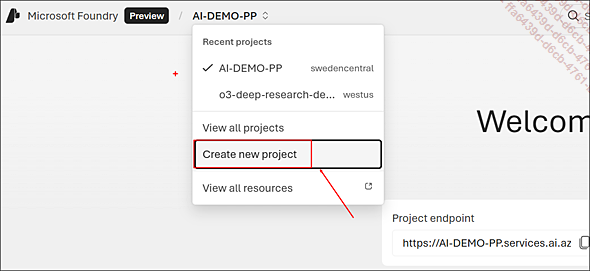

Cliquez sur Microsoft Foundry en haut à gauche de l’interface puis sur le bouton Create new project.

Dans le champ Project name, saisissez projet-ia-livre. Développez Advanced options et, si nécessaire, saisissez le nom du groupe de ressources qui hébergera vos ressources (dans mon cas, RG-AI-DEMO).

Cliquez sur le bouton Create. Après quelques instants, cliquez...

RAG

Retrieval-Augmented Generation (RAG), ou génération augmentée par la recherche, est une approche d’IA qui combine un modèle de langage (LLM ou SLM) pré-entraîné avec un système de recherche documentaire afin d’enrichir les réponses du modèle par des données propres à l’entreprise.

Cette méthode est née de la constatation que les LLM traditionnels sont limités à ce qu’ils ont appris lors de leur entraînement : leurs connaissances peuvent être obsolètes (elles s’arrêtent à une certaine date) et incomplètes vis-à-vis des informations privées ou spécialisées de l’organisation. Le RAG comble ces lacunes en permettant au LLM d’exploiter des documents, bases de connaissances ou données à jour fournies au moment de la question, plutôt que de s’en tenir uniquement à son corpus de données interne.

Le RAG interroge vos sources de données en temps réel et ajoute ces informations au prompt du LLM. Le modèle génère alors une réponse contextualisée, ancrée sur vos données et plus précise que si le LLM était laissé seul.

Concrètement, lorsqu’un utilisateur pose une question dans un système RAG, le processus se déroule en plusieurs étapes :

1. Sa question en langage naturel sert de requête pour chercher des documents pertinents (dans une base de connaissances interne, un index documentaire, etc.).

2. Les passages les plus pertinents trouvés sont récupérés (retrieval) et combinés avec la question de l’utilisateur.

3. Cet ensemble (« question + extraits récupérés ») est fourni en entrée au modèle génératif qui va produire la réponse finale.

4. La réponse du modèle est ainsi « augmentée » par des faits tirés des documents et peut éventuellement faire référence aux sources utilisées comme nous allons le voir avec Foundry.

Par exemple, si l’utilisateur demande « Quelles sont les règles de sécurité pour installer telle alarme ? », le système...

Protocole MCP

Le protocole MCP (Model Context Protocol) est un standard ouvert qui vise à simplifier et unifier la manière dont les assistants IA accèdent à des données externes et des outils. On le décrit souvent comme le « port USB-C de l’IA » : un connecteur universel permettant de brancher n’importe quelle source de connaissance ou service à un modèle de langage.

Né à la fin de l’année 2024 sous l’impulsion d’Anthropic (créateur du modèle Claude) et rapidement soutenu par Microsoft et d’autres acteurs, MCP fournit une interface standardisée (basée sur JSON-RPC) pour connecter un agent IA à des sources de contexte variées (base documentaire, API, etc.) sans avoir à développer d’intégrations spécifiques pour chaque cas.

En pratique, MCP permet à un assistant conversationnel (comme un agent dans Microsoft Foundry, ou un copilote GitHub) de découvrir et d’utiliser dynamiquement des « outils » et données externes fournis par des serveurs MCP. Au lieu de coder manuellement chaque connexion (lire une base de données, appeler un service métier…), l’administrateur implémente un serveur MCP pour son système.

Le modèle de langage, lui, sert de client MCP : il peut interroger tout serveur conforme au standard pour obtenir un renseignement ou effectuer une action. Cette standardisation apporte une double promesse : « connecter une source de données une fois, l’utiliser partout » et « intégrer un agent IA une fois, lui donner accès à tout ».

En d’autres termes, un outil disponible via MCP peut être utilisé par n’importe quel assistant compatible, et inversement un assistant MCP sait utiliser n’importe quel outil exposé via ce protocole.

Mais pourquoi MCP est-il apparu ?

Avant MCP, chaque intégration d’un agent IA à un système externe était un cas particulier : il fallait souvent développer une fonction Azure spécifique, ou écrire un plug-in dédié par API, pour chaque source de données ou action envisagée. Cela entraînait un coût...

Foundry local

Foundry Local est la déclinaison dans un environnement local de Microsoft Foundry, permettant d’exécuter des modèles de langage directement sur un poste de travail Windows (ou Mac) sans passer par le cloud Azure.

En d’autres termes, c’est une infrastructure IA embarquée sur votre machine, offrant les avantages d’une latence faible, du fonctionnement hors-ligne (pas besoin de connexion Internet) et d’une meilleure confidentialité des données, puisque les informations restent traitées en local. Foundry Local apporte ainsi la puissance des modèles open source de Microsoft Foundry aux appareils clients, en réduisant les coûts cloud et en privilégiant la personnalisation.

Lancé en préversion en 2025, il fonctionne aujourd’hui sur Windows 11 et macOS (Intel ou Apple Silicon), avec une intégration privilégiée dans Windows via la couche Windows AI Foundry (composants IA natifs de Windows 11).

L’installation de Foundry Local sur Windows s’effectue en quelques minutes grâce à l’outil de gestion de packages Winget fourni avec Windows 10/11.

Nous allons installer Foundry Local sur notre poste de travail Windows puis déployer le modèle sous licence Apache 2.0 gpt-oss-20b, performant sur les tâches de raisonnement et très efficace pour utiliser des outils....

Editions ENI Livres | Vidéos | e-Formations

Editions ENI Livres | Vidéos | e-Formations